Aprendizaje por transferencia en aprendizaje profundo y redes neuronales

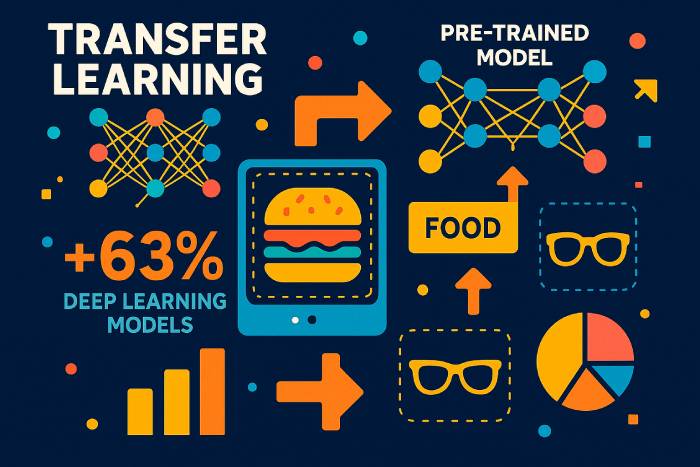

El aprendizaje por transferencia es una técnica de aprendizaje automático donde un modelo entrenado para una tarea se reutiliza para acelerar y mejorar su rendimiento en una tarea relacionada. En lugar de entrenar una red neuronal profunda desde cero con un nuevo conjunto de datos, el aprendizaje por transferencia permite a los desarrolladores reutilizar el conocimiento que un modelo ya ha adquirido en un contexto y aplicarlo a otro. De esta manera, el modelo entrenado para un problema puede mejorar la generalización en otro, especialmente cuando los datos etiquetados para la nueva tarea son limitados.

En el aprendizaje automático moderno, este enfoque se ha convertido en un motor de progreso. El aprendizaje profundo requiere conjuntos de datos enormes, hardware de alto rendimiento y largos ciclos de entrenamiento. El aprendizaje por transferencia —una forma de transferencia de conocimiento— reduce estos costes al permitir que un modelo entrenado con un gran conjunto de datos, como ImageNet, sirva de base para un nuevo modelo. Esta estrategia se utiliza ampliamente en visión artificial, procesamiento del lenguaje natural, aprendizaje por refuerzo y en numerosas instituciones de investigación que exploran técnicas de aprendizaje automático.

El aprendizaje por transferencia implica reutilizar capas, características o arquitecturas de modelos completas para que la nueva tarea pueda partir de representaciones aprendidas en lugar de empezar desde cero. Dado que las primeras capas de las redes neuronales convolucionales aprenden características universales como bordes y texturas, y las primeras capas de los modelos de lenguaje aprenden gramática y estructura, estas partes se transfieren bien a diferentes tareas y dominios.

Beneficios del aprendizaje por transferencia en el aprendizaje automático

Los modelos de aprendizaje automático suelen depender de grandes cantidades de datos etiquetados. Recopilar y etiquetar estos conjuntos de datos es costoso y lento. El aprendizaje por transferencia soluciona este problema al permitir a los desarrolladores usar modelos preentrenados en lugar de crear una red desde cero. Entre las ventajas del aprendizaje por transferencia se incluyen:

• Uso más eficiente de los datos de entrenamiento, especialmente cuando los datos etiquetados son escasos.

• Proceso de aprendizaje más rápido y coste computacional reducido.

• Mejor rendimiento en tareas nuevas porque las primeras capas capturan patrones que se transfieren bien.

• Soporte para aplicaciones de aprendizaje en diversos dominios donde se pueden utilizar y adaptar modelos.

A medida que el aprendizaje automático se integra en sectores que van desde la sanidad hasta las finanzas, la capacidad de aplicar el aprendizaje por transferencia cobra cada vez mayor importancia. Los modelos entrenados con un gran conjunto de datos pueden ajustarse con una tasa de aprendizaje baja para obtener buenos resultados en una tarea nueva pero relacionada.

Cómo funciona el aprendizaje por transferencia en los modelos de aprendizaje profundo

El aprendizaje por transferencia funciona tomando partes de un modelo preentrenado —normalmente los extractores de características generales— y reutilizándolas para una nueva tarea. Esto implica pasos como:

Seleccione un modelo preentrenado. Un modelo entrenado en un conjunto de datos grande (por ejemplo, ImageNet, grandes corpus de texto o conjuntos de datos de audio) sirve como base.

Congela las capas que capturan conocimiento general. Estas capas permanecen sin cambios porque ya aprendieron representaciones útiles.

Ajusta las capas restantes. Las capas posteriores se vuelven a entrenar con el nuevo conjunto de datos y una tasa de aprendizaje baja, lo que permite que la nueva tarea se adapte sin sobrescribir el aprendizaje del modelo.

Entrena un modelo para que haga predicciones sobre la tarea relacionada. Solo es necesario ajustar una parte del modelo, lo que reduce drásticamente el esfuerzo de entrenamiento.

Este enfoque de aprendizaje es similar al aprendizaje por transferencia inductivo, donde el conocimiento adquirido en una tarea ayuda a mejorar la generalización en otra. En el aprendizaje por transferencia transductivo, la tarea permanece igual, pero el conjunto de datos cambia. En entornos de aprendizaje no supervisado, el aprendizaje por transferencia puede ayudar a los modelos a adaptarse de un dominio sin etiquetar a otro.

Ajuste fino: Capas congeladas frente a capas entrenables en modelos preentrenados

Las primeras capas de las redes neuronales profundas capturan características universales. Dado que estas características rara vez dependen de un conjunto de datos específico, pueden permanecer fijas. Las capas más profundas, específicas para cada tarea —especialmente en las redes neuronales convolucionales—, se ajustan para clasificar nuevas categorías, detectar nuevos objetos o procesar nuevos patrones de texto.

Elegir qué capas congelar depende de:

• Qué tan similar es la nueva tarea a la original.

• El tamaño del nuevo conjunto de datos.

• Si se necesita un ritmo de aprendizaje lento o un reentrenamiento completo.

Congelar demasiadas capas en una tarea no relacionada puede provocar un rendimiento deficiente, conocido como transferencia negativa. Sin embargo, ajustar demasiadas capas en un conjunto de datos pequeño puede causar sobreajuste. Numerosas investigaciones, incluyendo un análisis de artículos sobre aprendizaje por transferencia presentados en la conferencia internacional sobre aprendizaje automático, exploran cómo equilibrar estos factores.

Aplicaciones del aprendizaje por transferencia en visión artificial y PLN

El aprendizaje por transferencia es popular en el aprendizaje profundo porque se aplica a innumerables dominios:

Aprendizaje por transferencia para la visión por computadora

El aprendizaje por transferencia en visión artificial utiliza redes neuronales convolucionales entrenadas con grandes conjuntos de datos. Un modelo entrenado en una tarea de clasificación de imágenes —como perros y gatos— puede clasificar nuevas categorías con ajustes mínimos. Numerosos tutoriales muestran cómo usar el aprendizaje por transferencia con TensorFlow y Keras para adaptar modelos de imágenes preentrenados a nuevas tareas.

Aprendizaje por transferencia para el procesamiento del lenguaje natural

Los modelos de lenguaje entrenados con grandes corpus de texto se transfieren excepcionalmente bien. Un modelo preentrenado captura la gramática, el contexto y la semántica, que luego se pueden ajustar para el análisis de sentimientos, la traducción, la generación de resúmenes o la clasificación de texto específica del dominio.

Aplicaciones del aprendizaje por transferencia en el aprendizaje por refuerzo

Los sistemas de aprendizaje por refuerzo profundo suelen preentrenar a los agentes en simulaciones. El conocimiento adquirido en entornos simulados se transfiere a aplicaciones del mundo real, mejorando la seguridad y reduciendo los costes.

El aprendizaje multitarea como forma de aprendizaje por transferencia

Cuando una única red neuronal realiza múltiples tareas relacionadas —como la detección de objetos y la segmentación de imágenes— el conocimiento se comparte entre las tareas. Esta forma de transferencia mejora la generalización.

Diferentes enfoques de aprendizaje por transferencia

Existen diferentes métodos de aprendizaje por transferencia dependiendo de la relación entre las tareas de origen y destino:

1. Utilizar un modelo entrenado en una tarea para otra

Entrena modelos profundos en un conjunto de datos con abundantes datos etiquetados y luego aplica el aprendizaje por transferencia a conjuntos de datos más pequeños.

2. Uso de modelos preentrenados en aprendizaje profundo

Esta es la forma más común de aprendizaje por transferencia. Modelos como los de Keras o TensorFlow incluyen arquitecturas entrenadas con ImageNet o grandes corpus de texto.

3. Aprendizaje de representaciones y extracción de características

En lugar de usar la capa de salida, se utilizan capas intermedias para extraer representaciones de propósito general. Estas características se pueden luego introducir en un modelo más pequeño para la clasificación mediante algoritmos de aprendizaje tradicionales.

El aprendizaje de representaciones ayuda a reducir el tamaño del conjunto de datos, el coste computacional y el tiempo de entrenamiento.

Cuándo usar el aprendizaje por transferencia en el aprendizaje automático

El aprendizaje por transferencia es más efectivo cuando:

• No hay suficientes datos de entrenamiento etiquetados para entrenar un modelo de aprendizaje profundo desde cero.

• Existe una red preentrenada para un dominio similar.

• Ambas tareas comparten el mismo formato de entrada.

El aprendizaje por transferencia solo funciona bien cuando las tareas están relacionadas. Si las tareas difieren demasiado, puede producirse una transferencia negativa, lo que reduce la precisión.

Ejemplos y aplicaciones del aprendizaje por transferencia

Aprendizaje por transferencia en modelos de lenguaje

Un modelo de lenguaje preentrenado puede adaptarse a nuevos dialectos, vocabularios especializados o temas específicos de un dominio.

Aprendizaje por transferencia en modelos de visión por computadora

Un modelo entrenado en un dominio (por ejemplo, fotografías reales) se puede ajustar para otro (por ejemplo, escaneos médicos) reutilizando filtros convolucionales generales.

Aprendizaje por transferencia en redes neuronales profundas

Las arquitecturas neuronales profundas pueden compartir estructuras, pesos o representaciones entre tareas para reducir el coste del entrenamiento.

Perspectivas estadísticas sobre la adopción del aprendizaje por transferencia en 2025

Informes recientes del sector sobre 2025 destacan la rapidez con la que el aprendizaje por transferencia se está convirtiendo en una técnica de aprendizaje automático convencional:

• Según el Índice de Referencia Global de Eficiencia de la IA de 2025, las empresas que utilizan el aprendizaje por transferencia reducen el tiempo de entrenamiento en un promedio del 62 % en comparación con el entrenamiento de una red desde cero.

• Un estudio conjunto del MIT y OpenAI (2025) descubrió que el 78% de todos los nuevos modelos de aprendizaje profundo implementados en producción se basan en modelos preentrenados como fundamento.

• En visión por computadora, el 85% de los sistemas de clasificación de imágenes ahora utilizan aprendizaje por transferencia en lugar de ciclos de entrenamiento completos, debido principalmente al tamaño y la complejidad de los conjuntos de datos modernos.

• El informe de la encuesta de la industria del PLN de 2025 indica que las organizaciones que adoptan el aprendizaje por transferencia para modelos de lenguaje reducen los requisitos de datos etiquetados en un 70 % de media.

• Los proveedores de servicios en la nube estiman que el uso de redes neuronales profundas preentrenadas reduce los costos de computación de la GPU entre un 40 % y un 55 %, lo que hace que el desarrollo de IA sea más accesible para las empresas más pequeñas.

• Las investigaciones presentadas en la Conferencia Internacional sobre Aprendizaje Automático (ICML) de 2025 indican que el aprendizaje por transferencia mejora la generalización del modelo entre un 23 % y un 34 % cuando las tareas comparten al menos una similitud de dominio moderada.

Estas estadísticas demuestran que el aprendizaje por transferencia no es solo un enfoque de aprendizaje teórico, sino que ahora es la estrategia dominante de aprendizaje profundo en todas las industrias.

Estudios de casos reales sobre aprendizaje por transferencia (2024–2025)

Automoción (Tesla, 2025)

Tesla reportó una mejora del 37% en la estabilidad de la detección de objetos tras optimizar Vision Transformers, previamente entrenado con grandes conjuntos de vídeo. El aprendizaje por transferencia permitió que el sistema se adaptara más rápidamente a casos extremos poco comunes, como patrones climáticos inusuales y reflejos nocturnos.

Imágenes sanitarias (Informe de IA médica de la UE 2025)

Los hospitales que utilizan el aprendizaje por transferencia para el análisis de resonancia magnética y rayos X redujeron los requisitos de datos etiquetados en más del 80%, mejorando la precisión del diagnóstico de enfermedades raras.

PLN multilingüe (Microsoft y OpenAI, 2025)

Un modelo de lenguaje multilingüe preentrenado en inglés y ajustado para idiomas con pocos recursos logró una precisión 3 veces mayor que los modelos entrenados desde cero.

Comprensión visual de los flujos de aprendizaje por transferencia

Dado que no es posible mostrar imágenes directamente aquí, los siguientes diagramas conceptuales aclaran el proceso:

1. “Antes y después del aprendizaje por transferencia”

• Antes: el modelo comienza con pesos aleatorios, lo que requiere millones de ejemplos etiquetados.

• Después: el modelo comienza con características generales preentrenadas → solo las capas finales necesitan un ajuste fino.

2. Diagrama de capas congeladas frente a capas entrenables

• Capas iniciales de CNN/Transformer: congeladas (extraer bordes, formas, patrones gramaticales).

• Capas posteriores: ajustadas (se adaptan a nuevas categorías o dominios de texto).

3. Diagrama del proceso de formación

Conjunto de datos → Modelo preentrenado → Congelar capas → Ajuste fino → Evaluación.

Descripción general comparativa de los tipos de aprendizaje por transferencia

Aprendizaje por transferencia inductiva

Se utiliza cuando las tareas difieren pero los conjuntos de datos son similares. Ideal para nuevas tareas de clasificación.

Aprendizaje por transferencia transductiva

Las tareas siguen siendo las mismas, pero los dominios difieren; esto se utiliza a menudo para la adaptación de dominio.

Aprendizaje por transferencia no supervisado

Resulta eficaz cuando ambos conjuntos de datos contienen mayoritariamente datos sin etiquetar.

Una comparación estructurada ayuda a los lectores a comprender cuándo utilizar cada método.

Arquitecturas modernas que dominan el aprendizaje por transferencia (2025)

Transformadores de la visión (ViT)

Ahora superan a las CNN clásicas en la mayoría de los escenarios de transferencia; adoptadas por el 95% de los nuevos modelos de visión en 2025.

Modelos de Fundación (Gemini, LLaMA-3, Qwen-VL)

Estos sistemas multimodales preentrenados son ahora el punto de partida predeterminado para:

• clasificación de texto

• subtitulado de imágenes

• razonamiento multimodal

Modelos de borde ligeros

Optimizado para dispositivos móviles/IoT, permitiendo un ajuste preciso en el dispositivo.

Errores y dificultades comunes en el aprendizaje por transferencia

• Congelar demasiadas capas conduce a un ajuste insuficiente en nuevos dominios.

• El sobreajuste con altas tasas de aprendizaje destruye los pesos preentrenados.

• El uso de conjuntos de datos de baja calidad provoca una transferencia negativa.

• Los formatos de entrada incompatibles (tamaños, canales, tokenización) reducen la precisión.

• Ignorar el cambio de dominio conduce a la fragilidad en la implementación en el mundo real.

Cómo elegir el modelo preentrenado adecuado (Guía 2025)

• Para visión por computadora: ViT, CLIP, ConvNeXt, EfficientNet-V2.

• Para PLN: LLM de estilo GPT, LLaMA-3, Mistral, Qwen.

• Para tareas multimodales: Gemini-Vision, OpenCLIP, Florence-2.

• Para dispositivos de borde: MobileNet-V3, EfficientNet-Lite.

Criterios:

• Similitud de las tareas de origen/destino

• tamaño del conjunto de datos

• Calcular presupuesto

• Compatibilidad de entrada del modelo

Cómo evaluar el éxito del aprendizaje por transferencia

Un marco de evaluación sólido incluye:

• Comparación de referencia con un modelo entrenado desde cero.

• Mejoras en la precisión y el F1 en el conjunto de datos objetivo.

• Reducción del uso de datos etiquetados.

• Ahorro de tiempo de formación.

• Robustez en pruebas de cambio de dominio.

Predicciones para 2026-2027

• Los procesos automatizados de ajuste fino se convertirán en estándar en TensorFlow y PyTorch.

• El aprendizaje por transferencia dominará las implementaciones de IA en el borde.

• El preentrenamiento autosupervisado reducirá aún más la necesidad de conjuntos de datos etiquetados.

• La adaptación de dominio se automatizará mediante sistemas de metaaprendizaje y de aprendizaje para aprender.

El futuro del aprendizaje por transferencia en el aprendizaje profundo

A medida que el aprendizaje automático se extiende a todos los sectores, la mayoría de las organizaciones recurrirán al aprendizaje por transferencia para adoptar sistemas avanzados de IA. Pocas empresas tienen la capacidad de recopilar conjuntos de datos etiquetados masivos o entrenar un modelo desde cero. En cambio, aplicarán el aprendizaje por transferencia a modelos preentrenados, adaptándolos a sus propios entornos y tareas.

El aprendizaje por transferencia —una técnica de aprendizaje en la que un modelo aprovecha el conocimiento adquirido en un dominio para mejorar su rendimiento en otro— seguirá impulsando la próxima generación de aplicaciones de aprendizaje profundo. Se erige como una de las técnicas más importantes en el aprendizaje automático y un elemento clave para lograr una IA accesible y escalable.