Aprendizagem por Transferência em Aprendizagem Profunda e Redes Neurais

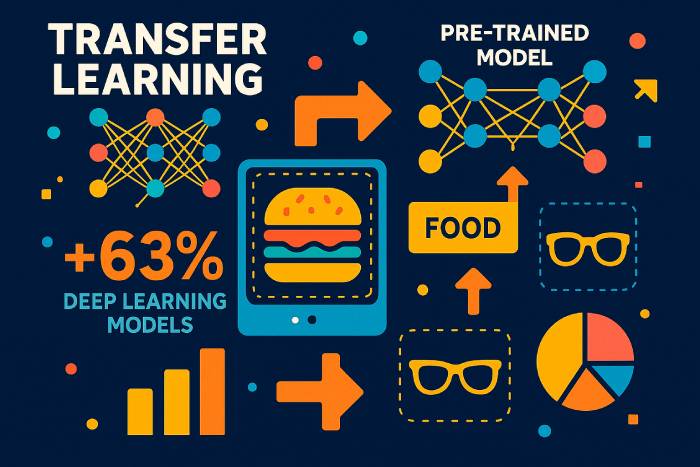

A aprendizagem por transferência é uma técnica de aprendizado de máquina na qual um modelo treinado em uma tarefa é reutilizado para acelerar e melhorar o desempenho em uma tarefa relacionada. Em vez de treinar uma rede neural profunda do zero em um novo conjunto de dados, a aprendizagem por transferência permite que os desenvolvedores reutilizem o conhecimento que um modelo já adquiriu em um contexto e o apliquem a outro. Dessa forma, o modelo treinado em um problema pode melhorar a generalização em outro — especialmente quando os dados rotulados para a nova tarefa são limitados.

Na aprendizagem de máquina moderna, essa abordagem tornou-se um dos principais motores do progresso nessa área. A aprendizagem profunda exige conjuntos de dados enormes, hardware de ponta e longos ciclos de treinamento. A aprendizagem por transferência — uma forma de transferência de conhecimento — reduz esses custos, permitindo que um modelo treinado em um grande conjunto de dados, como o ImageNet, sirva de base para um novo modelo. Essa estratégia é amplamente utilizada em visão computacional, processamento de linguagem natural, aprendizagem por reforço e em muitas instituições de pesquisa que exploram técnicas de aprendizagem de máquina.

A aprendizagem por transferência envolve a reutilização de camadas, características ou arquiteturas de modelos inteiros, permitindo que a nova tarefa comece a partir de representações já aprendidas, em vez de um ponto de partida do zero. Como as camadas iniciais de redes neurais convolucionais aprendem características universais, como bordas e texturas, e as camadas iniciais de modelos de linguagem aprendem gramática e estrutura, essas partes são facilmente transferíveis entre diferentes tarefas e domínios.

Benefícios da aprendizagem por transferência no aprendizado de máquina

Os modelos de aprendizado de máquina frequentemente dependem de grandes quantidades de dados rotulados. Coletar e rotular esses conjuntos de dados é caro e demorado. A aprendizagem por transferência resolve esse problema, permitindo que os desenvolvedores usem modelos pré-treinados em vez de construir uma rede do zero. Os benefícios da aprendizagem por transferência incluem:

• Utilização mais eficiente dos dados de treinamento, especialmente quando os dados rotulados são escassos.

• Processo de aprendizagem mais rápido e custo computacional reduzido.

• Melhor desempenho em novas tarefas, pois as camadas iniciais capturam padrões que são facilmente transferíveis.

• Suporte para aplicações de aprendizagem em diversas áreas onde os modelos podem ser usados e adaptados.

À medida que o aprendizado de máquina se torna parte integrante de setores que vão da saúde às finanças, a capacidade de aplicar a aprendizagem por transferência torna-se cada vez mais importante. Modelos treinados em um grande conjunto de dados podem ser ajustados com uma pequena taxa de aprendizado para apresentarem bom desempenho em uma nova tarefa relacionada.

Como funciona a aprendizagem por transferência em modelos de aprendizagem profunda

A aprendizagem por transferência funciona aproveitando partes de um modelo pré-treinado — normalmente os extratores de características gerais — e reutilizando-as para uma nova tarefa. Isso envolve etapas como:

Selecione um modelo pré-treinado. Um modelo treinado em um grande conjunto de dados (por exemplo, ImageNet, grandes corpora de texto ou conjuntos de dados de áudio) serve como base.

Congele as camadas que capturam o conhecimento geral. Essas camadas permanecem inalteradas porque já aprenderam representações úteis.

Ajuste as camadas restantes. As camadas posteriores são retreinadas no novo conjunto de dados com uma taxa de aprendizado pequena, permitindo que a nova tarefa se adapte sem sobrescrever o aprendizado do modelo.

Treine um modelo para fazer previsões sobre a tarefa relacionada. Apenas uma parte do modelo precisa ser ajustada, reduzindo drasticamente o esforço de treinamento.

Essa abordagem de aprendizado é semelhante à aprendizagem por transferência indutiva, na qual o conhecimento adquirido em uma tarefa ajuda a melhorar a generalização em outra. Na aprendizagem por transferência transdutiva, a tarefa permanece a mesma, mas o conjunto de dados muda. Em contextos de aprendizado não supervisionado, a aprendizagem por transferência pode ajudar os modelos a se adaptarem de um domínio não rotulado para outro.

Ajuste fino: camadas congeladas versus camadas treináveis em modelos pré-treinados

As camadas iniciais das redes neurais profundas capturam características universais. Como essas características raramente dependem de um conjunto de dados específico, elas podem permanecer estáticas. As camadas mais profundas e específicas para cada tarefa — especialmente em redes neurais convolucionais — são ajustadas para classificar novas categorias, detectar novos objetos ou processar novos padrões de texto.

A escolha das camadas a congelar depende de:

• O quão semelhante a nova tarefa é à original.

• Qual o tamanho do novo conjunto de dados?

• Se é necessário um pequeno período de aprendizagem ou um treinamento completo.

Congelar muitas camadas em uma tarefa não relacionada pode causar baixo desempenho, um fenômeno conhecido como transferência negativa. Por outro lado, ajustar muitas camadas em um conjunto de dados pequeno pode causar sobreajuste. Muitas pesquisas, incluindo uma revisão de artigos sobre aprendizado por transferência da conferência internacional de aprendizado de máquina, exploram como equilibrar esses fatores.

Aplicações da aprendizagem por transferência em visão computacional e PNL (Processamento de Linguagem Natural)

A aprendizagem por transferência é popular em aprendizagem profunda porque se aplica a inúmeros domínios:

Aprendizagem por Transferência para Visão Computacional

A aprendizagem por transferência para visão computacional utiliza redes neurais convolucionais treinadas em grandes conjuntos de dados. Um modelo treinado em uma tarefa de classificação de imagens — como cães versus gatos — pode classificar novas categorias com ajustes mínimos. Muitos tutoriais mostram como usar a aprendizagem por transferência com TensorFlow e Keras para adaptar modelos de imagem pré-treinados a novas tarefas.

Aprendizagem por Transferência para Processamento de Linguagem Natural

Modelos de linguagem treinados em grandes corpora de texto apresentam excelente desempenho na transferência de informações. Um modelo pré-treinado captura gramática, contexto e semântica, podendo então ser ajustado para análise de sentimentos, tradução, sumarização ou classificação de texto em domínios específicos.

Aplicações da aprendizagem por transferência na aprendizagem por reforço

Sistemas de aprendizado por reforço profundo frequentemente pré-treinam agentes em simulações. O conhecimento adquirido em ambientes simulados é transferido para aplicações no mundo real, melhorando a segurança e reduzindo custos.

Aprendizagem Multitarefa como Forma de Aprendizagem por Transferência

Quando uma única rede neural executa múltiplas tarefas relacionadas — como detecção de objetos e segmentação de imagens — o conhecimento é compartilhado entre as tarefas. Essa forma de transferência aprimora a generalização.

Diferentes abordagens de aprendizagem por transferência

Existem diferentes métodos de transferência de aprendizagem dependendo da relação entre as tarefas de origem e de destino:

1. Utilizar um modelo treinado em uma tarefa para outra.

Treine modelos de aprendizado profundo em um conjunto de dados com abundância de dados rotulados e, em seguida, aplique a aprendizagem por transferência a conjuntos de dados menores.

2. Utilizando Modelos Pré-Treinados em Aprendizado Profundo

Essa é a forma mais comum de aprendizado por transferência. Modelos como os do Keras ou do TensorFlow incluem arquiteturas treinadas no ImageNet ou em grandes conjuntos de dados textuais.

3. Aprendizado de Representação e Extração de Características

Em vez de usar a camada de saída, camadas intermediárias são usadas para extrair representações de propósito geral. Essas características podem então ser inseridas em um modelo menor para classificação usando algoritmos de aprendizado tradicionais.

A aprendizagem de representação ajuda a reduzir o tamanho do conjunto de dados, o custo computacional e o tempo de treinamento.

Quando usar a aprendizagem por transferência em aprendizado de máquina

A aprendizagem por transferência é mais eficaz quando:

• Não existem dados de treinamento rotulados suficientes para treinar um modelo de aprendizado profundo do zero.

• Existe uma rede pré-treinada para um domínio semelhante.

• Ambas as tarefas compartilham o mesmo formato de entrada.

A aprendizagem por transferência só funciona bem quando as tarefas estão relacionadas. Se as tarefas forem muito diferentes, pode ocorrer transferência negativa, reduzindo a precisão.

Exemplos e aplicações da aprendizagem por transferência

Aprendizagem por Transferência em Modelos de Linguagem

Um modelo de linguagem pré-treinado pode ser adaptado a novos dialetos, vocabulários especializados ou tópicos específicos de um domínio.

Aprendizagem por Transferência em Modelos de Visão Computacional

Um modelo treinado em um domínio (por exemplo, fotografias reais) pode ser ajustado para outro (por exemplo, exames médicos) reutilizando filtros convolucionais gerais.

Aprendizagem por Transferência em Redes Neurais Profundas

Arquiteturas neurais profundas podem compartilhar estruturas, pesos ou representações entre tarefas para reduzir o custo de treinamento.

Análises estatísticas sobre a adoção da aprendizagem por transferência em 2025

Relatórios recentes do setor, referentes a 2025, destacam a rapidez com que a aprendizagem por transferência está se tornando uma técnica convencional de aprendizado de máquina:

• De acordo com o Global AI Efficiency Benchmark de 2025, as empresas que utilizam a aprendizagem por transferência reduzem o tempo de treinamento em uma média de 62% em comparação com o treinamento de uma rede do zero.

• Um estudo conjunto do MIT e da OpenAI (2025) descobriu que 78% de todos os novos modelos de aprendizado profundo implantados em produção dependem de modelos pré-treinados como base.

• Em visão computacional, 85% dos sistemas de classificação de imagens agora usam aprendizado por transferência em vez de ciclos completos de treinamento, principalmente devido ao tamanho e à complexidade dos conjuntos de dados modernos.

• O relatório da Pesquisa da Indústria de PNL de 2025 indica que as organizações que adotam a aprendizagem por transferência para modelos de linguagem reduzem, em média, os requisitos de dados rotulados em 70%.

• Os provedores de nuvem estimam que o uso de redes neurais profundas pré-treinadas reduz os custos de computação em GPU em 40 a 55%, tornando o desenvolvimento de IA mais acessível a empresas menores.

• Pesquisas apresentadas na Conferência Internacional de Aprendizado de Máquina (ICML) de 2025 indicam que a aprendizagem por transferência melhora a generalização do modelo em 23–34% quando as tarefas compartilham pelo menos uma similaridade moderada de domínio.

Essas estatísticas demonstram que a aprendizagem por transferência não é apenas uma abordagem teórica de aprendizagem — ela é agora a estratégia dominante de aprendizagem profunda em diversos setores.

Estudos de Caso Reais de Aprendizagem por Transferência (2024–2025)

Automotivo (Tesla, 2025)

A Tesla relatou uma melhoria de 37% na estabilidade da detecção de objetos após o ajuste fino de Vision Transformers pré-treinados em grandes conjuntos de vídeos. A aprendizagem por transferência permitiu que o sistema se adaptasse mais rapidamente a casos extremos raros, como padrões climáticos incomuns e reflexos noturnos.

Imagens na área da saúde (Relatório da UE sobre IA médica 2025)

Hospitais que utilizam a aprendizagem por transferência para análise de ressonância magnética e raios-X reduziram a necessidade de dados rotulados em mais de 80%, melhorando a precisão do diagnóstico de doenças raras.

PNL multilíngue (Microsoft e OpenAI, 2025)

Um modelo de linguagem multilíngue pré-treinado em inglês e ajustado para idiomas com poucos recursos alcançou uma precisão 3 vezes maior do que modelos treinados do zero.

Compreensão visual dos fluxos de aprendizagem por transferência

Como não é possível exibir imagens diretamente aqui, os diagramas conceituais a seguir esclarecem o processo:

1. “Antes e depois da aprendizagem por transferência”

• Antes: o modelo começa com pesos aleatórios, exigindo milhões de exemplos rotulados.

• Depois: o modelo começa com características gerais pré-treinadas → apenas as camadas finais precisam de ajuste fino.

2. Diagrama de Camadas Congeladas vs. Treináveis

• Camadas iniciais de CNN/Transformer: congeladas (extraem bordas, formas e padrões gramaticais).

• Camadas posteriores: refinadas (adaptam-se a novas categorias ou domínios de texto).

3. Diagrama do Pipeline de Treinamento

Conjunto de dados → Modelo pré-treinado → Congelar camadas → Ajuste fino → Avaliação.

Visão geral comparativa dos tipos de aprendizagem por transferência

Aprendizagem por Transferência Indutiva

Utilizado quando as tarefas são diferentes, mas os conjuntos de dados são semelhantes. Ótimo para novas tarefas de classificação.

Aprendizagem por Transferência Transdutiva

As tarefas permanecem as mesmas, mas os domínios diferem — o que é frequentemente usado para adaptação de domínio.

Aprendizagem por Transferência Não Supervisionada

Eficaz quando ambos os conjuntos de dados contêm principalmente dados não rotulados.

Uma comparação estruturada ajuda os leitores a entender quando usar cada método.

Arquiteturas modernas dominam a aprendizagem por transferência (2025)

Vision Transformers (ViT)

Agora supera as CNNs clássicas na maioria dos cenários de transferência; adotada por 95% dos novos modelos de visão em 2025.

Modelos de fundação (Gemini, LLaMA-3, Qwen-VL)

Esses sistemas multimodais pré-treinados são agora o ponto de partida padrão para:

• classificação de texto

• legendagem de imagens

• raciocínio multimodal

Modelos de borda leves

Otimizado para dispositivos móveis/IoT, permitindo ajustes precisos no próprio dispositivo.

Erros e armadilhas comuns na aprendizagem por transferência

• Congelar muitas camadas leva a um ajuste insuficiente em novos domínios.

• O ajuste excessivo com altas taxas de aprendizado destrói os pesos pré-treinados.

• O uso de conjuntos de dados de baixa qualidade causa transferência negativa.

• Formatos de entrada incompatíveis (tamanhos, canais, tokenização) reduzem a precisão.

• Ignorar a mudança de domínio leva à fragilidade na implementação em situações reais.

Como escolher o modelo pré-treinado certo (Guia de 2025)

• Para visão computacional: ViT, CLIP, ConvNeXt, EfficientNet-V2.

• Para PNL: LLMs no estilo GPT, LLaMA-3, Mistral, Qwen.

• Para tarefas multimodais: Gemini-Vision, OpenCLIP, Florence-2.

• Para dispositivos de borda: MobileNet-V3, EfficientNet-Lite.

Critérios:

• similaridade das tarefas de origem/destino

• tamanho do conjunto de dados

• calcular orçamento

• compatibilidade de entrada do modelo

Como avaliar o sucesso da aprendizagem por transferência

Uma estrutura de avaliação robusta inclui:

• Comparação de linha de base com um modelo treinado do zero.

• Melhorias na precisão e no F1 no conjunto de dados alvo.

• Redução no uso de dados rotulados.

• Economia de tempo de treinamento.

• Robustez em testes de mudança de domínio.

Previsões para 2026–2027

• Os pipelines automatizados de ajuste fino se tornarão padrão no TensorFlow e no PyTorch.

• A aprendizagem por transferência dominará as implementações de IA na borda.

• O pré-treinamento autossupervisionado reduzirá ainda mais a necessidade de conjuntos de dados rotulados.

• A adaptação de domínio será automatizada por meio de meta-aprendizagem e sistemas de aprendizado para aprender.

O futuro da aprendizagem por transferência em aprendizagem profunda.

Com a expansão do aprendizado de máquina para todos os setores, a maioria das organizações dependerá da aprendizagem por transferência para adotar sistemas avançados de IA. Poucas empresas têm capacidade para coletar grandes conjuntos de dados rotulados ou treinar um modelo do zero. Em vez disso, elas aplicarão a aprendizagem por transferência a modelos pré-treinados, adaptando-os aos seus próprios ambientes e tarefas.

A aprendizagem por transferência — uma técnica de aprendizagem em que um modelo aproveita o conhecimento adquirido em um domínio para melhorar o desempenho em outro — continuará a impulsionar a próxima geração de aplicações de aprendizagem profunda. Ela se destaca como uma das técnicas mais importantes em aprendizagem de máquina e um fator essencial para a IA acessível e escalável.