ディープラーニングとニューラルネットワークにおける転移学習

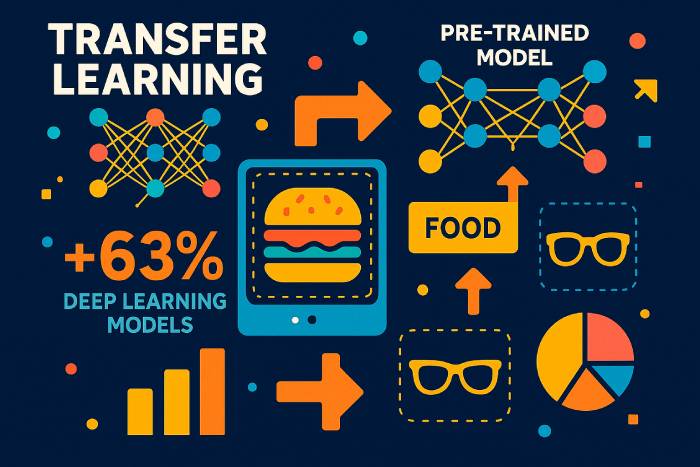

転移学習とは、あるタスクで学習した学習モデルを再利用し、関連するタスクのパフォーマンスを高速化・向上させる機械学習手法です。新しいデータセットでディープニューラルネットワークをゼロから学習させる代わりに、転移学習では、モデルが既にある設定で学習した知識を再利用し、別の設定に適用することができます。これにより、ある問題で学習したモデルは、別の問題における汎化能力を向上させることができます。特に、新しいタスクのラベル付きデータが限られている場合に有効です。

現代の機械学習において、このアプローチは機械学習の進歩を牽引する原動力となっています。ディープラーニングには膨大なデータセット、ハイエンドハードウェア、そして長い学習サイクルが必要です。知識移転の一種である転移学習は、ImageNetのような大規模データセットで学習したモデルを新しいモデルのベースとして利用することで、これらのコストを削減します。この戦略は、コンピュータービジョン、自然言語処理、強化学習、そして機械学習の技術を研究する多くの研究機関で広く利用されています。

転移学習では、層、特徴、あるいはモデルアーキテクチャ全体を再利用することで、新しいタスクを白紙の状態からではなく、学習済みの表現から開始することができます。畳み込みニューラルネットワークの初期層はエッジやテクスチャといった普遍的な特徴を学習し、言語モデルの初期層は文法や構造を学習するため、これらの要素は異なるタスクや領域間で容易に転移します。

機械学習における転移学習の利点

機械学習モデルは、多くの場合、膨大な量のラベル付きデータに依存します。このようなデータセットの収集とラベル付けには、コストと時間がかかります。転移学習は、開発者がネットワークをゼロから構築するのではなく、事前学習済みのモデルを利用できるようにすることで、この問題に対処します。転移学習の利点は次のとおりです。

• 特にラベル付きデータが不足している場合のトレーニング データのより効率的な使用。

• 学習プロセスの高速化と計算コストの削減。

• 初期のレイヤーで適切に転送されるパターンがキャプチャされるため、新しいタスクでのパフォーマンスが向上します。

• モデルを使用および適応できるドメイン全体にわたる学習アプリケーションのサポート。

機械学習が医療から金融に至るまで、様々な業界で不可欠な要素となるにつれ、転移学習を適用する能力の重要性はますます高まっています。大規模なデータセットで学習されたモデルは、低い学習率で微調整することで、関連性のある新しいタスクで優れたパフォーマンスを発揮できるようになります。

ディープラーニングモデルにおける転移学習の仕組み

転移学習は、事前学習済みモデルの一部(通常は一般的な特徴抽出器)を新しいタスクに再利用することで機能します。これには、次のような手順が含まれます。

事前学習済みモデルを選択します。大規模なデータセット(ImageNet、大規模テキストコーパス、音声データセットなど)で学習されたモデルがベースとなります。

一般知識を捉えたレイヤーをフリーズします。これらのレイヤーは既に有用な表現を学習しているため、変更されません。

残りのレイヤーを微調整します。後続のレイヤーは、新しいデータセットで小さな学習率で再トレーニングされ、モデルの学習を上書きすることなく新しいタスクに適応できるようになります。

関連するタスクについて予測を行うようにモデルをトレーニングします。モデルの一部を調整するだけで済むため、トレーニングにかかる労力を大幅に削減できます。

この学習アプローチは、あるタスクで学習した知識が別のタスクの汎化を向上させる帰納的転移学習に似ています。トランスダクティブ転移学習では、タスクは同じままですが、データセットが変化します。教師なし学習の設定では、転移学習はモデルがラベルなしのドメインから別のドメインに適応するのに役立ちます。

微調整: 事前学習済みモデルにおける固定レイヤーと学習可能レイヤー

ディープニューラルネットワークの初期層は、普遍的な特徴を捉えます。これらの特徴は特定のデータセットに依存することはほとんどないため、固定されたままにすることができます。より深い、タスク固有の層、特に畳み込みニューラルネットワークでは、新しいカテゴリを分類したり、新しいオブジェクトを検出したり、新しいテキストパターンを処理したりするために微調整されます。

フリーズするレイヤーの選択は、次の要素によって決まります。

• 新しいタスクが元のタスクとどの程度類似しているか。

• 新しいデータセットの大きさ。

• 小さな学習率または完全な再トレーニングが必要かどうか。

無関係なタスクに多くのレイヤーを固定すると、ネガティブ・トランスファーと呼ばれるパフォーマンス低下を引き起こす可能性があります。しかし、小規模なデータセットに多くのレイヤーを微調整すると、過学習を引き起こす可能性があります。機械学習に関する国際会議における転移学習論文の調査など、多くの研究がこれらの要因のバランスをとる方法を探求しています。

コンピュータビジョンとNLPにおける転移学習の応用

転移学習は、数え切れないほど多くの分野に適用できるため、ディープラーニングでは人気があります。

コンピュータビジョンのための転移学習

コンピュータービジョンにおける転移学習は、大規模なデータセットで学習された畳み込みニューラルネットワークを使用します。犬と猫の分類といった単一の画像分類タスクで学習したモデルは、最小限の調整で新しいカテゴリーを分類できます。多くのチュートリアルでは、TensorFlowとKerasを用いた転移学習を用いて、事前学習済みの画像モデルを新しいタスクに適応させる方法を紹介しています。

自然言語処理のための転移学習

大規模なテキストコーパスでトレーニングされた言語モデルは、非常に優れた転送性能を発揮します。事前トレーニング済みのモデルは文法、文脈、意味を捉え、感情分析、翻訳、要約、あるいはドメイン固有のテキスト分類のために微調整することができます。

強化学習における転移学習の応用

深層強化学習システムでは、多くの場合、シミュレーションでエージェントを事前学習します。シミュレーション環境で得られた知識は現実世界のアプリケーションに応用され、安全性の向上とコスト削減につながります。

転移学習の一形態としてのマルチタスク学習

単一のニューラルネットワークが複数の関連タスク(物体検出や画像セグメンテーションなど)を実行する場合、知識はタスク間で共有されます。この転送形式によって、汎化能力が向上します。

さまざまな転移学習アプローチ

ソース タスクとターゲット タスクの関係に応じて、さまざまな転移学習方法が存在します。

1. あるタスクで訓練したモデルを別のタスクに使用する

豊富なラベル付きデータを含むデータセットでディープモデルをトレーニングし、その後、より小さなデータセットに転移学習を適用します。

2. ディープラーニングにおける事前学習済みモデルの使用

これは転移学習の最も一般的な形式です。KerasやTensorFlowなどのモデルには、ImageNetや大規模テキストコーパスで学習されたアーキテクチャが含まれています。

3. 表現学習と特徴抽出

出力層の代わりに中間層を用いて汎用的な表現を抽出します。これらの特徴は、従来の学習アルゴリズムを用いた分類のためのより小規模なモデルに入力することができます。

表現学習は、データセットのサイズ、計算コスト、トレーニング時間を削減するのに役立ちます。

機械学習で転移学習を使用するタイミング

転移学習は次のような場合に最も効果的です。

• ディープラーニング モデルをゼロからトレーニングするには、ラベル付けされたトレーニング データが不十分です。

• 同様のドメインに対して事前トレーニング済みのネットワークが存在します。

• 両方のタスクは同じ入力形式を共有します。

転移学習は、タスクが関連している場合にのみうまく機能します。タスクが大きく異なる場合、負の転移が発生し、精度が低下する可能性があります。

転移学習の例と応用

言語モデルにおける転移学習

事前トレーニング済みの言語モデルは、新しい方言、専門用語、またはドメイン固有のトピックに適応できます。

コンピュータビジョンモデルにおける転移学習

あるドメイン(例:実際の写真)でトレーニングされたモデルは、一般的な畳み込みフィルターを再利用することで、別のドメイン(例:医療スキャン)向けに微調整できます。

ディープニューラルネットワークにおける転移学習

ディープ ニューラル アーキテクチャでは、タスク間で構造、重み、または表現を共有して、トレーニング コストを削減できます。

2025年の転移学習導入に関する統計的洞察

最近の 2025 年の業界レポートでは、転移学習がいかに急速に主流の機械学習手法になりつつあるかが強調されています。

• 2025年グローバルAI効率ベンチマークによると、転移学習を使用する企業は、ネットワークをゼロからトレーニングする場合と比較して、トレーニング時間を平均62%短縮します。

• MITとOpenAI(2025年)の共同研究によると、本番環境に導入された新しいディープラーニングモデルの78%が、事前トレーニング済みモデルを基盤として利用していることがわかりました。

• コンピューター ビジョンでは、最新のデータセットのサイズと複雑さが主な理由で、画像分類システムの 85% が完全なトレーニング サイクルではなく転移学習を使用しています。

• 2025 年のNLP 業界調査によると、言語モデルに転移学習を採用している組織では、ラベル付きデータ要件が平均で 70% 削減されています。

• クラウドプロバイダーは、事前トレーニング済みのディープニューラルネットワークを使用すると GPU コンピューティングコストが 40~55% 削減され、中小企業でも AI 開発が容易になると見積もっています。

• 2025年の国際機械学習会議(ICML)で発表された研究によると、タスクが少なくとも中程度のドメイン類似性を共有する場合、転移学習によってモデルの一般化が23~34%向上することが示されています。

これらの統計は、転移学習が単なる理論的な学習アプローチではなく、現在では業界全体で主流のディープラーニング戦略であることを示しています。

転移学習の実例研究(2024~2025年)

自動車(テスラ、2025年)

テスラは、大規模なビデオコーパスで事前学習済みのVision Transformersを微調整した結果、物体検出の安定性が37%向上したと報告しました。転移学習により、システムは異常な気象パターンや夜間の反射といった稀なエッジケースにもより迅速に適応できるようになりました。

ヘルスケアイメージング(EU医療AIレポート2025)

MRI および X 線分析に転移学習を使用する病院では、ラベル付きデータ要件が 80% 以上削減され、希少疾患の診断精度が向上しました。

多言語NLP(Microsoft & OpenAI、2025年)

英語で事前トレーニングされ、リソースの少ない言語向けに微調整された多言語モデルは、ゼロからトレーニングされたモデルよりも 3 倍の精度を達成しました。

転移学習パイプラインの視覚的な理解

ここでは画像を直接表示することはできないため、次の概念図でプロセスを明確にします。

1. 「転移学習前と転移学習後」

• 以前: モデルはランダムな重みから開始され、数百万のラベル付きの例が必要になります。

• 後: モデルは事前トレーニング済みの一般的な特徴から開始されます → 最終レイヤーのみ微調整が必要です。

2. 固定レイヤーとトレーニング可能なレイヤーの図

• 初期の CNN/Transformer レイヤー: 凍結 (エッジ、形状、文法パターンを抽出)。

• 後続のレイヤー: 微調整されます (新しいカテゴリまたはテキスト ドメインに適応します)。

3. トレーニングパイプライン図

データセット → 事前トレーニング済みモデル → レイヤーのフリーズ → 微調整 → 評価。

転移学習の種類の比較概要

帰納的転移学習

タスクは異なるがデータセットは類似している場合に使用します。新しい分類タスクに最適です。

トランスダクティブ・トランスファー・ラーニング

タスクは同じですが、ドメインは異なります。これは、ドメイン適応によく使用されます。

教師なし転移学習

両方のデータセットにラベルのないデータがほとんど含まれている場合に有効です。

構造化された比較により、読者はそれぞれの方法をいつ使用すべきかを理解できるようになります。

転移学習を支配する現代アーキテクチャ(2025年)

ビジョントランスフォーマー(ViT)

現在、ほとんどの転送シナリオで従来の CNN よりも優れたパフォーマンスを発揮し、2025 年には新しいビジョン モデルの 95% に採用される予定です。

基礎モデル(ジェミニ、LLaMA-3、Qwen-VL)

これらの事前トレーニング済みのマルチモーダル システムは、現在、次のもののデフォルトの出発点となっています。

• テキスト分類

• 画像キャプション

• マルチモーダル推論

軽量エッジモデル

モバイル/IoT デバイス向けに最適化されており、デバイス上での微調整が可能です。

転移学習におけるよくある間違いと落とし穴

• フリーズするレイヤーが多すぎると、新しいドメインでの適合不足につながります。

• 高い学習率で過剰にチューニングすると、事前にトレーニングされた重みが破壊されます。

• 低品質のデータセットを使用すると、転移が悪くなります。

• 入力形式(サイズ、チャネル、トークン化)が一致しないと、精度が低下します。

• ドメインシフトを無視すると、実際の展開において脆弱性が生じます。

適切な事前学習済みモデルの選び方(2025年ガイド)

• コンピューター ビジョンの場合: ViT、CLIP、ConvNeXt、EfficientNet-V2。

• NLP の場合: GPT スタイルの LLM、LLaMA-3、Mistral、Qwen。

• マルチモーダルタスクの場合: Gemini-Vision、OpenCLIP、Florence-2。

• エッジ デバイスの場合: MobileNet-V3、EfficientNet-Lite。

基準:

• ソース/ターゲットタスクの類似性

• データセットのサイズ

• 計算予算

• モデル入力の互換性

転移学習の成功を評価する方法

堅牢な評価フレームワークには以下が含まれます。

• 最初からトレーニングされたモデルとのベースライン比較。

• ターゲット データセットの精度と F1 が向上しました。

• ラベル付きデータの使用量の削減。

• トレーニング時間の節約。

• ドメインシフトテストにおける堅牢性。

2026~2027年の予測

• 自動化された微調整パイプラインは、TensorFlow と PyTorch で標準になります。

• 転移学習がエッジ AI の展開の中心となるでしょう。

• 自己教師型事前トレーニングにより、ラベル付きデータセットの必要性がさらに軽減されます。

• ドメイン適応はメタ学習と学習システムによって自動化されます。

ディープラーニングにおける転移学習の未来

機械学習があらゆる業界に浸透するにつれ、多くの組織は高度なAIシステムを導入するために転移学習を活用するようになるでしょう。大規模なラベル付きデータセットを収集したり、モデルをゼロから学習させたりできる企業は限られています。その代わりに、事前学習済みのモデルに転移学習を適用し、自社の環境やタスクに適応させていくでしょう。

転移学習(モデルがある領域で学習した知識を活用して別の領域のパフォーマンスを向上させる学習手法)は、次世代のディープラーニングアプリケーションを支え続けるでしょう。転移学習は機械学習における最も重要な手法の一つであり、アクセスしやすくスケーラブルなAIを実現する重要な要素です。