Трансферне навчання в глибокому навчанні та нейронних мережах

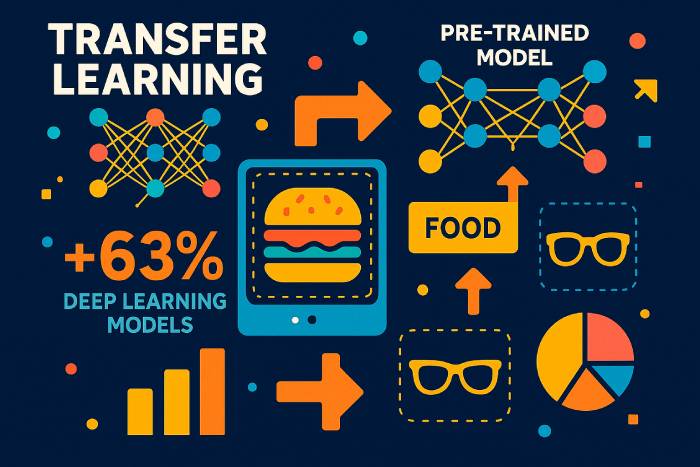

Трансферне навчання – це метод машинного навчання, за якого модель навчання, навчена на одному завданні, повторно використовується для пришвидшення та покращення продуктивності у пов'язаному завданні. Замість того, щоб навчати глибоку нейронну мережу з нуля на новому наборі даних, трансферне навчання дозволяє розробникам перевикористовувати знання, які модель вже вивчила в одному середовищі, та застосовувати їх до іншого. Таким чином, модель, навчена на одній проблемі, може покращити узагальнення в іншому, особливо коли марковані дані для нового завдання обмежені.

У сучасному машинному навчанні цей підхід став рушійною силою його прогресу. Глибоке навчання вимагає величезних наборів даних, високоякісного обладнання та тривалих циклів навчання. Трансферне навчання — форма передачі знань — зменшує ці витрати, дозволяючи моделі, навченій на великому наборі даних, такому як ImageNet, служити основою для нової моделі. Ця стратегія широко використовується в комп'ютерному зорі, обробці природної мови, навчанні з підкріпленням, а також у багатьох дослідницьких установах, які досліджують методи машинного навчання.

Трансферне навчання передбачає повторне використання шарів, ознак або цілих архітектур моделей, щоб нове завдання могло починатися з вивчених представлень, а не з чистого аркуша. Оскільки попередні шари згорткових нейронних мереж вивчають універсальні ознаки, такі як ребра та текстури, а попередні шари мовних моделей вивчають граматику та структуру, ці частини добре переносяться між різними завданнями та доменами.

Переваги трансферного навчання в машинному навчанні

Моделі машинного навчання часто залежать від величезної кількості маркованих даних. Збір та маркування таких наборів даних є дорогим та повільним процесом. Трансферне навчання вирішує цю проблему, дозволяючи розробникам використовувати попередньо навчені моделі замість того, щоб створювати мережу з нуля. Переваги трансферного навчання включають:

• Більш ефективне використання навчальних даних, особливо за обмеженості маркованих даних.

• Швидший процес навчання та зменшення обчислювальних витрат.

• Краща продуктивність при виконанні нових завдань, оскільки ранні шари фіксують шаблони, які добре передаються.

• Підтримка навчальних програм у різних областях, де моделі можна використовувати та адаптувати.

Оскільки машинне навчання стає невід'ємною частиною галузей, починаючи від охорони здоров'я і закінчуючи фінансами, здатність застосовувати трансферне навчання стає все більш важливою. Моделі, навчені на великому наборі даних, можна точно налаштувати з невеликою швидкістю навчання для ефективного виконання нового, але пов'язаного завдання.

Як працює трансферне навчання в моделях глибокого навчання

Трансферне навчання працює шляхом повторного використання частин попередньо навченої моделі — зазвичай загальних екстракторів ознак — для нового завдання. Це включає такі кроки, як:

Виберіть попередньо навчену модель. Модель, навчена на великому наборі даних (наприклад, ImageNet, великих текстових корпусах або аудіонаборах), слугує основою.

Заморозьте шари, що містять загальні знання. Ці шари залишаються незмінними, оскільки вони вже вивчили корисні представлення.

Точно налаштуйте решту шарів. Пізніші шари перенавчаються на новому наборі даних з невеликою швидкістю навчання, що дозволяє новому завданню адаптуватися без перезапису навчання моделі.

Навчіть модель робити прогнози щодо відповідного завдання. Потрібно скоригувати лише частину моделі, що значно скорочує зусилля на навчання.

Цей підхід до навчання схожий на індуктивне трансферне навчання, де знання, отримані в одному завданні, допомагають покращити узагальнення в іншому. У трансдуктивному трансферному навчанні завдання залишається тим самим, але набір даних змінюється. В умовах навчання без учителя трансферне навчання може допомогти моделям адаптуватися з однієї немаркованої області до іншої.

Точне налаштування: заморожені та навчальні шари в попередньо навчених моделях

Ранні шари глибоких нейронних мереж фіксують універсальні ознаки. Оскільки ці ознаки рідко залежать від конкретного набору даних, вони можуть залишатися замороженими. Глибші, специфічні для задач шари, особливо в згорткових нейронних мережах, налаштовуються для класифікації нових категорій, виявлення нових об'єктів або обробки нових текстових шаблонів.

Вибір шарів для заморожування залежить від:

• Наскільки нове завдання схоже на початкове.

• Наскільки великий або малий новий набір даних.

• Чи потрібен невеликий рівень навчання, чи повна перепідготовка.

Заморожування занадто великої кількості шарів на непов'язаному завданні може призвести до низької продуктивності, відомої як негативний перенос. Але точне налаштування занадто великої кількості шарів на невеликому наборі даних може призвести до перенавчання. Багато досліджень, включаючи опитування щодо статей про трансферне навчання на міжнародній конференції з машинного навчання, досліджують, як збалансувати ці фактори.

Застосування трансферного навчання в комп'ютерному зорі та НЛП

Трансферне навчання популярне в глибокому навчанні, оскільки воно застосовується в незліченних областях:

Трансферне навчання для комп'ютерного зору

Трансферне навчання для комп'ютерного зору використовує згорткові нейронні мережі, навчені на великих наборах даних. Модель, навчена на одному завданні класифікації зображень, наприклад, собаки проти котів, може класифікувати нові категорії з мінімальними коригуваннями. Багато навчальних посібників показують, як використовувати трансферне навчання з TensorFlow та Keras для адаптації попередньо навчених моделей зображень до нових завдань.

Трансферне навчання для обробки природної мови

Мовні моделі надзвичайно добре навчаються на масивних текстових корпусах. Попередньо навчена модель фіксує граматику, контекст і семантику, які потім можна точно налаштувати для аналізу настроїв, перекладу, узагальнення або класифікації тексту за предметною областю.

Застосування трансферного навчання в навчанні з підкріпленням

Системи глибокого навчання з підкріпленням часто попередньо навчають агентів у симуляціях. Знання, отримані в змодельованих середовищах, переносяться в реальні програми, підвищуючи безпеку та знижуючи витрати.

Багатозадачне навчання як форма трансферного навчання

Коли одна нейронна мережа виконує кілька пов'язаних завдань, таких як виявлення об'єктів та сегментація зображень, знання передаються між завданнями. Така форма передачі покращує узагальнення.

Різні підходи до трансферного навчання

Існують різні методи трансферного навчання залежно від взаємозв'язку між вихідним та цільовим завданнями:

1. Використання моделі, навченої на одному завданні, для іншого

Навчайте глибокі моделі на наборі даних з великою кількістю розмічених даних, а потім застосовуйте трансферне навчання до менших наборів даних.

2. Використання попередньо навчених моделей у глибокому навчанні

Це найпоширеніша форма трансферного навчання. Моделі, такі як у Keras або TensorFlow, включають архітектури, навчені на ImageNet або великих текстових корпусах.

3. Навчання представлень та вилучення ознак

Замість використання вихідного шару, для вилучення представлень загального призначення використовуються проміжні шари. Ці ознаки потім можна внести до меншої моделі для класифікації за допомогою традиційних алгоритмів навчання.

Навчання представлень допомагає зменшити розмір набору даних, обчислювальні витрати та час навчання.

Коли використовувати трансферне навчання в машинному навчанні

Трансферне навчання є найефективнішим, коли:

• Немає достатньо маркованих навчальних даних для навчання моделі глибокого навчання з нуля.

• Для подібного домену існує попередньо навчена мережа.

• Обидва завдання використовують однаковий формат вхідних даних.

Трансферне навчання працює добре лише тоді, коли завдання пов'язані між собою. Якщо завдання занадто сильно відрізняються, може виникнути негативний трансфер, що знижує точність.

Приклади та застосування трансферного навчання

Трансферне навчання в мовних моделях

Попередньо навчену мовну модель можна адаптувати до нових діалектів, спеціалізованих словників або предметно-орієнтованих тем.

Трансферне навчання в моделях комп'ютерного зору

Модель, навчену на одній області (наприклад, реальні фотографії), можна точно налаштувати для іншої (наприклад, медичні скани) шляхом повторного використання загальних згорткових фільтрів.

Трансферне навчання в глибоких нейронних мережах

Глибокі нейронні архітектури можуть спільно використовувати структури, ваги або представлення між завданнями для зниження витрат на навчання.

Статистичні дані щодо впровадження трансферного навчання за 2025 рік

Нещодавні галузеві звіти за 2025 рік підкреслюють, як швидко трансферне навчання стає основною технікою машинного навчання:

• Згідно з Глобальним бенчмарком ефективності штучного інтелекту за 2025 рік, компанії, що використовують трансферне навчання, скорочують час навчання в середньому на 62% порівняно з навчанням мережі з нуля.

• Спільне дослідження MIT та OpenAI (2025) показало, що 78% усіх нових моделей глибокого навчання, розгорнутих у виробництві, спираються на попередньо навчені моделі як основу.

• У комп'ютерному зорі 85% систем класифікації зображень зараз використовують перенесення навчання, а не повні цикли навчання, значною мірою через розмір і складність сучасних наборів даних.

• Згідно з опитуванням галузі NLP за 2025 рік, організації, які впроваджують трансферне навчання для мовних моделей, скорочують вимоги до маркованих даних у середньому на 70%.

• Постачальники хмарних послуг оцінюють, що використання попередньо навчених глибоких нейронних мереж знижує витрати на обчислення на графічному процесорі на 40–55%, що робить розробку штучного інтелекту доступнішою для менших компаній.

• Дослідження, представлене на Міжнародній конференції з машинного навчання (ICML) 2025 року, показує, що трансферне навчання покращує узагальнення моделі на 23–34%, коли завдання мають принаймні помірну схожість предметних областей.

Ця статистика демонструє, що трансферне навчання — це не просто теоретичний підхід до навчання, а зараз це домінуюча стратегія глибокого навчання в різних галузях.

Реальні приклади навчання з трансферу (2024–2025)

Автомобільна промисловість (Tesla, 2025)

Tesla повідомила про покращення стабільності виявлення об'єктів на 37% після точного налаштування систем Vision Transformers, попередньо навчених на масивних відеокорпусах. Перехідне навчання дозволило системі швидше адаптуватися до рідкісних крайніх випадків, таких як незвичайні погодні умови та нічні відблиски.

Медична візуалізація (Звіт ЄС про медичний штучний інтелект за 2025 рік)

Лікарні, які використовують трансферне навчання для аналізу МРТ та рентгенівських знімків, зменшили вимоги до маркованих даних більш ніж на 80%, що підвищило точність діагностики рідкісних захворювань.

Багатомовне НЛП (Microsoft та OpenAI, 2025)

Багатомовна мовна модель, попередньо навчена англійською мовою та налаштована для мов з низьким рівнем ресурсів, досягла втричі кращої точності, ніж моделі, навчені з нуля.

Візуальне розуміння процесів трансферного навчання

Оскільки зображення не можуть бути показані тут безпосередньо, наступні концептуальні схеми пояснюють процес:

1. «До та після трансферного навчання»

• До: модель починається з випадкових вагових коефіцієнтів, що вимагає мільйонів позначених прикладів.

• Після: модель починається з попередньо навчених загальних ознак → лише завершальні шари потребують точного налаштування.

2. Діаграма заморожених та навчальних шарів

• Ранні шари CNN/Transformer: заморожені (вилучення ребер, форм, граматичних шаблонів).

• Пізніші шари: доопрацьовано (адаптовано до нових категорій або текстових доменів).

3. Діаграма навчального конвеєра

Набір даних → Попередньо навчена модель → Заморожування шарів → Точне налаштування → Оцінювання.

Порівняльний огляд типів трансферного навчання

Індуктивне трансферне навчання

Використовується, коли завдання відрізняються, але набори даних схожі. Чудово підходить для нових завдань класифікації.

Трансдуктивне трансферне навчання

Завдання залишаються незмінними, але домени відрізняються — часто використовуються для адаптації домену.

Самонавчальне трансферне навчання

Ефективно, коли обидва набори даних містять переважно немарковані дані.

Структуроване порівняння допомагає читачам зрозуміти, коли використовувати кожен метод.

Сучасні архітектури домінують у трансферному навчанні (2025)

Трансформери Бачення (ViT)

Тепер перевершують класичні CNN у більшості сценаріїв перенесення; у 2025 році їх впровадили 95% нових моделей зору.

Моделі фундаменту (Gemini, LLaMA-3, Qwen-VL)

Ці попередньо навчені мультимодальні системи тепер є відправною точкою за замовчуванням для:

• класифікація тексту

• підписи до зображень

• мультимодальне мислення

Легкі моделі з краями

Оптимізовано для мобільних/IoT пристроїв, що дозволяє точно налаштувати на пристрої.

Поширені помилки та пастки у трансферному навчанні

• Заморожування занадто великої кількості шарів призводить до недостатнього налаштування на нових доменах.

• Надмірне налаштування з високими швидкостями навчання руйнує попередньо навчені ваги.

• Використання низькоякісних наборів даних призводить до негативного перенесення.

• Невідповідність форматів вхідних даних (розміри, канали, токенізація) знижує точність.

• Ігнорування зсуву домену призводить до крихкості під час реального розгортання.

Як вибрати правильну попередньо навчену модель (Посібник 2025 року)

• Для комп’ютерного зору: ViT, CLIP, ConvNeXt, EfficientNet-V2.

• Для НЛП: LLM у стилі GPT, LLaMA-3, Mistral, Qwen.

• Для мультимодальних завдань: Gemini-Vision, OpenCLIP, Florence-2.

• Для периферійних пристроїв: MobileNet-V3, EfficientNet-Lite.

Критерії:

• подібність завдань джерела/цілі

• розмір набору даних

• розрахувати бюджет

• сумісність вхідних даних моделі

Як оцінити успіх трансферного навчання

Надійна система оцінювання включає:

• Порівняння базових даних з моделлю, навченою з нуля.

• Покращення точності та F1 на цільовому наборі даних.

• Зменшення використання маркованих даних.

• Економія часу на навчання.

• Стійкість до тестів на зсув домену.

Прогнози на 2026–2027 роки

• Автоматизовані конвеєри точного налаштування стануть стандартними в TensorFlow та PyTorch.

• Трансферне навчання домінуватиме у розгортанні периферійного штучного інтелекту.

• Самостійне попереднє навчання ще більше зменшить потребу в маркованих наборах даних.

• Адаптація предметної області стане автоматизованою за допомогою систем метанавчання та навчання для навчання.

Майбутнє трансферного навчання в глибокому навчанні

Оскільки машинне навчання поширюється в усі галузі, більшість організацій покладатимуться на трансферне навчання для впровадження передових систем штучного інтелекту. Мало які компанії мають можливість збирати величезні набори даних з маркуванням або навчати модель з нуля. Натомість вони застосовуватимуть трансферне навчання до попередньо навчених моделей, адаптуючи їх до власного середовища та завдань.

Трансферне навчання — техніка навчання, за якої модель використовує знання, отримані в одній області, для покращення продуктивності в іншій — продовжуватиме рухати наступне покоління програм глибокого навчання. Воно є однією з найважливіших технік машинного навчання та ключовим фактором, що сприяє створенню доступного та масштабованого штучного інтелекту.