Học chuyển giao trong học sâu và mạng nơ-ron

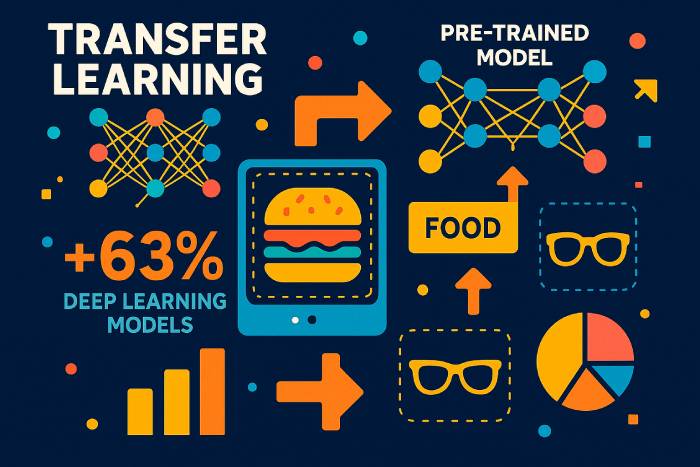

Học chuyển giao là một kỹ thuật học máy, trong đó mô hình học được huấn luyện trên một tác vụ được tái sử dụng để tăng tốc và cải thiện hiệu suất trên một tác vụ liên quan. Thay vì huấn luyện một mạng nơ-ron sâu từ đầu trên một tập dữ liệu mới, học chuyển giao cho phép các nhà phát triển tái sử dụng kiến thức mà một mô hình đã học được trong một bối cảnh và áp dụng nó vào một bối cảnh khác. Bằng cách này, mô hình được huấn luyện trên một bài toán có thể cải thiện khả năng khái quát hóa trong một bài toán khác — đặc biệt là khi dữ liệu được gắn nhãn cho tác vụ mới bị hạn chế.

Trong học máy hiện đại, phương pháp này đã trở thành động lực thúc đẩy sự tiến bộ của học máy. Học sâu đòi hỏi bộ dữ liệu khổng lồ, phần cứng cao cấp và chu kỳ đào tạo dài. Học chuyển giao — một hình thức chuyển giao kiến thức — giúp giảm thiểu những chi phí này bằng cách sử dụng một mô hình được đào tạo trên một bộ dữ liệu lớn như ImageNet làm cơ sở cho một mô hình mới. Chiến lược này được sử dụng rộng rãi trong thị giác máy tính, xử lý ngôn ngữ tự nhiên, học tăng cường và nhiều tổ chức nghiên cứu đang khám phá các kỹ thuật trong học máy.

Học chuyển giao bao gồm việc tái sử dụng các lớp, đặc điểm hoặc toàn bộ kiến trúc mô hình để tác vụ mới có thể bắt đầu từ các biểu diễn đã học thay vì một trang giấy trắng. Vì các lớp trước đó của mạng nơ-ron tích chập học các đặc điểm phổ quát như cạnh và kết cấu, còn các lớp trước đó của mô hình ngôn ngữ học ngữ pháp và cấu trúc, nên các phần này có thể chuyển giao tốt giữa các tác vụ và miền khác nhau.

Lợi ích của học chuyển giao trong học máy

Các mô hình học máy thường phụ thuộc vào lượng lớn dữ liệu được gắn nhãn. Việc thu thập và gắn nhãn các tập dữ liệu như vậy rất tốn kém và chậm chạp. Học chuyển giao giải quyết vấn đề này bằng cách cho phép các nhà phát triển sử dụng các mô hình được đào tạo sẵn thay vì phải xây dựng mạng lưới từ đầu. Những lợi ích của học chuyển giao bao gồm:

• Sử dụng dữ liệu đào tạo hiệu quả hơn, đặc biệt là khi dữ liệu được gắn nhãn khan hiếm.

• Quá trình học nhanh hơn và giảm chi phí tính toán.

• Hiệu suất tốt hơn trên các tác vụ mới vì các lớp đầu tiên nắm bắt các mẫu có khả năng truyền tải tốt.

• Hỗ trợ các ứng dụng học tập trên nhiều miền nơi các mô hình có thể được sử dụng và điều chỉnh.

Khi học máy trở thành một phần không thể thiếu trong các ngành công nghiệp, từ chăm sóc sức khỏe đến tài chính, khả năng áp dụng học chuyển giao ngày càng quan trọng. Các mô hình được đào tạo trên một tập dữ liệu lớn có thể được tinh chỉnh với tốc độ học nhỏ để thực hiện tốt một tác vụ mới nhưng có liên quan.

Cách thức hoạt động của học chuyển giao trong các mô hình học sâu

Học chuyển giao hoạt động bằng cách lấy các phần của mô hình đã được đào tạo trước — thường là các trình trích xuất đặc trưng chung — và tái sử dụng chúng cho một tác vụ mới. Quá trình này bao gồm các bước như sau:

Chọn một mô hình được đào tạo trước. Mô hình được đào tạo trên một tập dữ liệu lớn (ví dụ: ImageNet, tập hợp văn bản lớn hoặc tập dữ liệu âm thanh) sẽ đóng vai trò là cơ sở.

Đóng băng các lớp nắm bắt kiến thức chung. Các lớp này không thay đổi vì chúng đã học được các biểu diễn hữu ích.

Tinh chỉnh các lớp còn lại. Các lớp sau được đào tạo lại trên tập dữ liệu mới với tốc độ học nhỏ, cho phép tác vụ mới thích ứng mà không ghi đè lên quá trình học của mô hình.

Huấn luyện mô hình để đưa ra dự đoán về nhiệm vụ liên quan. Chỉ cần điều chỉnh một phần của mô hình, giúp giảm đáng kể công sức huấn luyện.

Phương pháp học này tương tự như học chuyển giao quy nạp, trong đó kiến thức học được từ một tác vụ giúp cải thiện khả năng khái quát hóa trong tác vụ khác. Trong học chuyển giao chuyển đổi, tác vụ vẫn giữ nguyên nhưng tập dữ liệu thay đổi. Trong môi trường học không giám sát, học chuyển giao có thể giúp các mô hình thích ứng từ miền không có nhãn này sang miền không có nhãn khác.

Tinh chỉnh: Lớp đông lạnh so với lớp có thể đào tạo trong các mô hình được đào tạo trước

Các lớp đầu tiên của mạng nơ-ron sâu nắm bắt các đặc điểm phổ quát. Vì các đặc điểm này hiếm khi phụ thuộc vào một tập dữ liệu cụ thể, chúng có thể được giữ nguyên. Các lớp sâu hơn, dành riêng cho từng tác vụ — đặc biệt là trong mạng nơ-ron tích chập — được tinh chỉnh để phân loại các danh mục mới, phát hiện đối tượng mới hoặc xử lý các mẫu văn bản mới.

Việc lựa chọn lớp nào để đông lạnh phụ thuộc vào:

• Nhiệm vụ mới giống với nhiệm vụ ban đầu như thế nào.

• Bộ dữ liệu mới lớn hay nhỏ.

• Cần tốc độ học tập nhỏ hay cần đào tạo lại toàn bộ.

Việc đóng băng quá nhiều lớp trên một tác vụ không liên quan có thể gây ra hiệu suất kém, được gọi là chuyển giao âm. Tuy nhiên, việc tinh chỉnh quá nhiều lớp trên một tập dữ liệu nhỏ có thể gây ra hiện tượng quá khớp. Nhiều nghiên cứu, bao gồm khảo sát về các bài báo học chuyển giao từ hội nghị quốc tế về học máy, đã tìm hiểu cách cân bằng các yếu tố này.

Ứng dụng của Học chuyển giao trong Thị giác máy tính và NLP

Học chuyển giao rất phổ biến trong học sâu vì nó áp dụng trên vô số lĩnh vực:

Học chuyển giao cho thị giác máy tính

Học chuyển giao cho thị giác máy tính sử dụng mạng nơ-ron tích chập được huấn luyện trên các tập dữ liệu lớn. Một mô hình được huấn luyện trên một tác vụ phân loại hình ảnh — chẳng hạn như chó so với mèo — có thể phân loại các danh mục mới với sự điều chỉnh tối thiểu. Nhiều hướng dẫn chỉ ra cách sử dụng học chuyển giao với TensorFlow và Keras để điều chỉnh các mô hình hình ảnh đã được huấn luyện trước cho các tác vụ mới.

Chuyển giao học tập cho xử lý ngôn ngữ tự nhiên

Các mô hình ngôn ngữ được đào tạo trên nền tảng chuyển giao văn bản khối lượng lớn cực kỳ tốt. Một mô hình được đào tạo trước sẽ nắm bắt ngữ pháp, ngữ cảnh và ngữ nghĩa, sau đó có thể được tinh chỉnh để phân tích cảm xúc, dịch thuật, tóm tắt hoặc phân loại văn bản theo từng lĩnh vực cụ thể.

Ứng dụng của học chuyển giao trong học tăng cường

Các hệ thống học tăng cường sâu thường huấn luyện trước các tác nhân trong mô phỏng. Kiến thức thu được trong môi trường mô phỏng được chuyển giao cho các ứng dụng thực tế, giúp cải thiện tính an toàn và giảm chi phí.

Học tập đa nhiệm vụ như một hình thức học tập chuyển giao

Khi một mạng nơ-ron duy nhất thực hiện nhiều tác vụ liên quan — chẳng hạn như phát hiện đối tượng và phân đoạn hình ảnh — kiến thức sẽ được chia sẻ giữa các tác vụ. Hình thức chuyển giao này giúp tăng cường khả năng khái quát hóa.

Các phương pháp học chuyển giao khác nhau

Có nhiều phương pháp học chuyển giao khác nhau tùy thuộc vào mối quan hệ giữa nhiệm vụ nguồn và nhiệm vụ đích:

1. Sử dụng mô hình được đào tạo cho một nhiệm vụ khác

Đào tạo các mô hình sâu trên một tập dữ liệu có nhiều dữ liệu được gắn nhãn, sau đó áp dụng phương pháp học chuyển giao cho các tập dữ liệu nhỏ hơn.

2. Sử dụng các mô hình được đào tạo trước trong học sâu

Đây là hình thức học chuyển giao phổ biến nhất. Các mô hình như trong Keras hoặc TensorFlow bao gồm các kiến trúc được đào tạo trên ImageNet hoặc các tập dữ liệu văn bản lớn.

3. Học biểu diễn và trích xuất đặc trưng

Thay vì sử dụng lớp đầu ra, các lớp trung gian được sử dụng để trích xuất các biểu diễn đa năng. Các đặc điểm này sau đó có thể được đưa vào một mô hình nhỏ hơn để phân loại bằng các thuật toán học truyền thống.

Học biểu diễn giúp giảm kích thước tập dữ liệu, chi phí tính toán và thời gian đào tạo.

Khi nào nên sử dụng học chuyển giao trong học máy

Học chuyển giao hiệu quả nhất khi:

• Không có đủ dữ liệu đào tạo được gắn nhãn để đào tạo mô hình học sâu từ đầu.

• Có một mạng lưới được đào tạo trước cho một miền tương tự.

• Cả hai tác vụ đều có cùng định dạng đầu vào.

Học chuyển giao chỉ hiệu quả khi các nhiệm vụ có liên quan. Nếu các nhiệm vụ khác nhau quá nhiều, hiện tượng chuyển giao tiêu cực có thể xảy ra, làm giảm độ chính xác.

Ví dụ và ứng dụng của học chuyển giao

Chuyển giao học tập trong các mô hình ngôn ngữ

Một mô hình ngôn ngữ được đào tạo trước có thể được điều chỉnh cho phù hợp với phương ngữ mới, từ vựng chuyên ngành hoặc chủ đề cụ thể theo từng lĩnh vực.

Học chuyển giao trong các mô hình thị giác máy tính

Một mô hình được đào tạo trên một miền (ví dụ: ảnh chụp thực tế) có thể được tinh chỉnh cho miền khác (ví dụ: quét y tế) bằng cách sử dụng lại các bộ lọc tích chập chung.

Học chuyển giao trong mạng nơ-ron sâu

Kiến trúc nơ-ron sâu có thể chia sẻ cấu trúc, trọng số hoặc biểu diễn giữa các tác vụ để giảm chi phí đào tạo.

Thông tin chi tiết thống kê năm 2025 về việc áp dụng học tập chuyển giao

Các báo cáo ngành gần đây năm 2025 nêu bật tốc độ học chuyển giao đang trở thành kỹ thuật học máy chính thống:

• Theo Tiêu chuẩn hiệu quả AI toàn cầu năm 2025, các công ty sử dụng phương pháp học chuyển giao có thể giảm thời gian đào tạo trung bình 62% so với đào tạo mạng từ đầu.

• Một nghiên cứu chung của MIT và OpenAI (2025) cho thấy 78% tất cả các mô hình học sâu mới được triển khai trong sản xuất đều dựa trên các mô hình được đào tạo trước làm nền tảng.

• Trong thị giác máy tính, 85% hệ thống phân loại hình ảnh hiện nay sử dụng phương pháp học chuyển giao thay vì chu kỳ đào tạo đầy đủ, chủ yếu là do quy mô và độ phức tạp của các tập dữ liệu hiện đại.

• Khảo sát ngành NLP năm 2025 báo cáo rằng các tổ chức áp dụng phương pháp học chuyển giao cho các mô hình ngôn ngữ đã cắt giảm trung bình 70% yêu cầu về dữ liệu được gắn nhãn.

• Các nhà cung cấp dịch vụ đám mây ước tính rằng việc sử dụng mạng nơ-ron sâu được đào tạo trước giúp giảm chi phí tính toán GPU từ 40–55%, giúp các công ty nhỏ dễ tiếp cận hơn với việc phát triển AI.

• Nghiên cứu được trình bày tại Hội nghị quốc tế về máy học (ICML) năm 2025 chỉ ra rằng học chuyển giao cải thiện khả năng khái quát hóa mô hình từ 23–34% khi các tác vụ có ít nhất mức độ tương đồng miền vừa phải.

Những số liệu thống kê này chứng minh rằng học chuyển giao không chỉ là một phương pháp học lý thuyết mà hiện nay đã trở thành chiến lược học sâu chiếm ưu thế trong nhiều ngành.

Các nghiên cứu điển hình thực tế về học chuyển giao (2024–2025)

Ô tô (Tesla, 2025)

Tesla báo cáo độ ổn định phát hiện vật thể được cải thiện 37% sau khi tinh chỉnh Vision Transformers được đào tạo trước trên các tập dữ liệu video khổng lồ. Học chuyển giao cho phép hệ thống thích ứng nhanh hơn với các trường hợp ngoại lệ hiếm gặp như kiểu thời tiết bất thường và phản xạ ban đêm.

Hình ảnh chăm sóc sức khỏe (Báo cáo AI y tế của EU năm 2025)

Các bệnh viện sử dụng phương pháp học chuyển giao để phân tích MRI và X-quang đã giảm hơn 80% yêu cầu về dữ liệu có nhãn, cải thiện độ chính xác của chẩn đoán đối với các bệnh hiếm gặp.

NLP đa ngôn ngữ (Microsoft & OpenAI, 2025)

Một mô hình ngôn ngữ đa ngôn ngữ được đào tạo trước bằng tiếng Anh và được tinh chỉnh cho các ngôn ngữ có ít tài nguyên đạt độ chính xác cao hơn 3 lần so với các mô hình được đào tạo từ đầu.

Hiểu biết trực quan về các đường ống học chuyển giao

Vì hình ảnh không thể hiển thị trực tiếp ở đây nên sơ đồ khái niệm sau đây sẽ làm rõ quá trình này:

1. “Trước và sau khi chuyển giao học tập”

• Trước: mô hình bắt đầu từ trọng số ngẫu nhiên, yêu cầu hàng triệu ví dụ được gắn nhãn.

• Sau đó: mô hình bắt đầu từ các đặc điểm chung được đào tạo trước → chỉ các lớp cuối cùng cần tinh chỉnh.

2. Biểu đồ lớp đông lạnh so với lớp có thể huấn luyện

• Các lớp CNN/Transformer ban đầu: đóng băng (trích xuất các cạnh, hình dạng, mẫu ngữ pháp).

• Các lớp sau: được tinh chỉnh (thích ứng với các danh mục hoặc miền văn bản mới).

3. Sơ đồ đường ống đào tạo

Bộ dữ liệu → Mô hình được đào tạo trước → Đóng băng các lớp → Tinh chỉnh → Đánh giá.

Tổng quan so sánh các loại hình học chuyển giao

Học chuyển giao quy nạp

Được sử dụng khi các tác vụ khác nhau nhưng tập dữ liệu lại tương tự. Phù hợp cho các tác vụ phân loại mới.

Học chuyển giao quy nạp

Nhiệm vụ vẫn giữ nguyên, nhưng miền thì khác nhau — thường được sử dụng để điều chỉnh miền.

Học chuyển giao không giám sát

Có hiệu quả khi cả hai tập dữ liệu đều chứa phần lớn dữ liệu chưa được gắn nhãn.

So sánh có cấu trúc giúp người đọc hiểu khi nào nên sử dụng từng phương pháp.

Kiến trúc hiện đại thống trị học chuyển giao (2025)

Vision Transformers (ViT)

Hiện nay vượt trội hơn CNN cổ điển trong hầu hết các tình huống chuyển giao; được 95% mô hình thị giác mới áp dụng vào năm 2025.

Các mô hình nền tảng (Gemini, LLaMA-3, Qwen-VL)

Các hệ thống đa phương thức được đào tạo trước này hiện là điểm khởi đầu mặc định cho:

• phân loại văn bản

• chú thích hình ảnh

• lý luận đa phương thức

Các mẫu Edge nhẹ

Được tối ưu hóa cho các thiết bị di động/IoT, cho phép tinh chỉnh trên thiết bị.

Những sai lầm và cạm bẫy thường gặp trong học chuyển giao

• Đóng băng quá nhiều lớp sẽ dẫn đến việc không khớp với các miền mới.

• Điều chỉnh quá mức với tỷ lệ học tập cao sẽ phá hủy các trọng số được đào tạo trước.

• Sử dụng bộ dữ liệu chất lượng thấp gây ra sự chuyển giao tiêu cực.

• Định dạng đầu vào không khớp (kích thước, kênh, mã thông báo) làm giảm độ chính xác.

• Bỏ qua sự thay đổi miền sẽ dẫn đến sự dễ vỡ trong quá trình triển khai thực tế.

Cách chọn mô hình được đào tạo trước phù hợp (Hướng dẫn năm 2025)

• Đối với thị giác máy tính: ViT, CLIP, ConvNeXt, EfficientNet-V2.

• Đối với NLP: LLM theo phong cách GPT, LLaMA-3, Mistral, Qwen.

• Đối với các tác vụ đa phương thức: Gemini-Vision, OpenCLIP, Florence-2.

• Dành cho thiết bị biên: MobileNet-V3, EfficientNet-Lite.

Tiêu chuẩn:

• sự tương đồng của nhiệm vụ nguồn/mục tiêu

• kích thước tập dữ liệu

• tính toán ngân sách

• khả năng tương thích đầu vào mô hình

Cách đánh giá thành công của việc học chuyển giao

Một khuôn khổ đánh giá mạnh mẽ bao gồm:

• So sánh cơ sở với mô hình được đào tạo từ đầu.

• Cải thiện độ chính xác và F1 trên tập dữ liệu mục tiêu.

• Giảm thiểu việc sử dụng dữ liệu có nhãn.

• Tiết kiệm thời gian đào tạo.

• Độ bền vững trong các thử nghiệm chuyển dịch miền.

Dự đoán cho năm 2026–2027

• Các quy trình tinh chỉnh tự động sẽ trở thành tiêu chuẩn trong TensorFlow và PyTorch.

• Học chuyển giao sẽ chi phối việc triển khai AI biên.

• Việc đào tạo trước có giám sát sẽ làm giảm nhu cầu về các tập dữ liệu được gắn nhãn hơn nữa.

• Việc thích ứng miền sẽ được tự động hóa thông qua các hệ thống siêu học và học để học.

Tương lai của học chuyển giao trong học sâu

Khi học máy mở rộng sang mọi ngành, hầu hết các tổ chức sẽ dựa vào học chuyển giao để áp dụng các hệ thống AI tiên tiến. Rất ít công ty có khả năng thu thập các tập dữ liệu được gắn nhãn khổng lồ hoặc đào tạo một mô hình từ đầu. Thay vào đó, họ sẽ áp dụng học chuyển giao vào các mô hình đã được đào tạo trước, điều chỉnh chúng cho phù hợp với môi trường và nhiệm vụ của riêng mình.

Học chuyển giao — một kỹ thuật học tập trong đó một mô hình tận dụng kiến thức đã học được trong một lĩnh vực để cải thiện hiệu suất trong một lĩnh vực khác — sẽ tiếp tục là động lực cho thế hệ ứng dụng học sâu tiếp theo. Đây là một trong những kỹ thuật quan trọng nhất trong học máy và là yếu tố then chốt cho phép AI dễ tiếp cận và có khả năng mở rộng.