Apprentissage par transfert dans l`apprentissage profond et les réseaux neuronaux

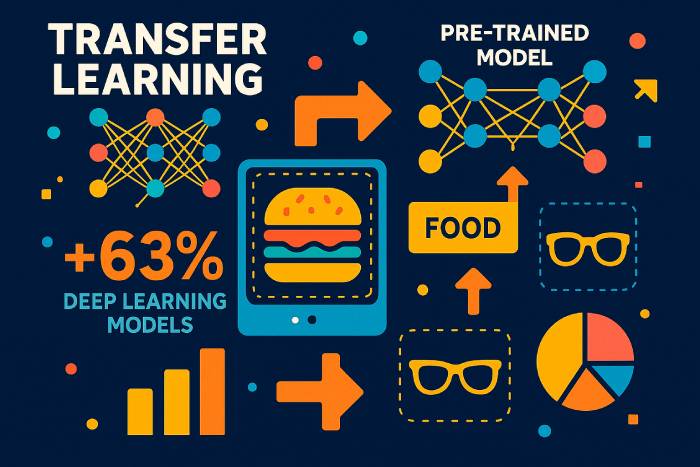

L'apprentissage par transfert est une technique d'apprentissage automatique qui consiste à réutiliser un modèle entraîné sur une tâche afin d'accélérer et d'améliorer ses performances sur une tâche similaire. Au lieu d'entraîner un réseau neuronal profond à partir de zéro sur un nouvel ensemble de données, l'apprentissage par transfert permet aux développeurs de réutiliser les connaissances acquises par un modèle dans un contexte donné et de les appliquer à un autre. Ainsi, le modèle entraîné sur un problème peut améliorer sa capacité de généralisation sur un autre, notamment lorsque les données étiquetées pour la nouvelle tâche sont limitées.

En apprentissage automatique moderne, cette approche est devenue un moteur de progrès. L'apprentissage profond exige d'énormes ensembles de données, du matériel haut de gamme et de longs cycles d'entraînement. L'apprentissage par transfert, une forme de transfert de connaissances, réduit ces coûts en permettant à un modèle entraîné sur un vaste ensemble de données tel qu'ImageNet de servir de base à un nouveau modèle. Cette stratégie est largement utilisée en vision par ordinateur, en traitement automatique du langage naturel, en apprentissage par renforcement et par de nombreux instituts de recherche explorant des techniques d'apprentissage automatique.

L'apprentissage par transfert consiste à réutiliser des couches, des caractéristiques ou des architectures de modèles entières afin que la nouvelle tâche puisse s'appuyer sur des représentations apprises plutôt que de partir de zéro. Étant donné que les premières couches des réseaux de neurones convolutifs apprennent des caractéristiques universelles telles que les contours et les textures, et que les premières couches des modèles de langage apprennent la grammaire et la structure, ces éléments se transfèrent efficacement d'une tâche à l'autre et d'un domaine à l'autre.

Avantages de l'apprentissage par transfert en apprentissage automatique

Les modèles d'apprentissage automatique dépendent souvent d'énormes quantités de données étiquetées. La collecte et l'étiquetage de tels ensembles de données sont coûteux et longs. L'apprentissage par transfert résout ce problème en permettant aux développeurs d'utiliser des modèles pré-entraînés au lieu de construire un réseau à partir de zéro. Les avantages de l'apprentissage par transfert sont les suivants :

• Une utilisation plus efficace des données d'entraînement, notamment lorsque les données étiquetées sont rares.

• Processus d'apprentissage plus rapide et coût de calcul réduit.

• Meilleures performances sur les nouvelles tâches car les premières couches capturent des modèles qui se transfèrent bien.

• Soutien aux applications d'apprentissage dans tous les domaines où les modèles peuvent être utilisés et adaptés.

L'apprentissage automatique étant devenu partie intégrante de secteurs aussi variés que la santé et la finance, la capacité d'appliquer l'apprentissage par transfert revêt une importance croissante. Les modèles entraînés sur un vaste ensemble de données peuvent être affinés avec un faible taux d'apprentissage pour obtenir de bonnes performances sur une tâche nouvelle mais connexe.

Comment fonctionne l'apprentissage par transfert dans les modèles d'apprentissage profond

L'apprentissage par transfert consiste à réutiliser des parties d'un modèle pré-entraîné (généralement les extracteurs de caractéristiques généraux) pour une nouvelle tâche. Cela implique des étapes telles que :

Sélectionnez un modèle pré-entraîné. Un modèle entraîné sur un vaste ensemble de données (par exemple, ImageNet, de grands corpus textuels ou des ensembles de données audio) sert de base.

Figez les couches qui capturent les connaissances générales. Ces couches restent inchangées car elles ont déjà appris des représentations utiles.

Affinez les couches restantes. Les couches suivantes sont réentraînées sur le nouveau jeu de données avec un faible taux d'apprentissage, permettant ainsi à la nouvelle tâche de s'adapter sans écraser l'apprentissage du modèle.

Entraînez un modèle à effectuer des prédictions sur la tâche correspondante. Seule une partie du modèle doit être ajustée, ce qui réduit considérablement l'effort d'entraînement.

Cette approche d'apprentissage est similaire à l'apprentissage par transfert inductif, où les connaissances acquises lors d'une tâche contribuent à améliorer la généralisation dans une autre. Dans l'apprentissage par transfert transductif, la tâche reste la même, mais l'ensemble de données change. En apprentissage non supervisé, l'apprentissage par transfert peut aider les modèles à s'adapter d'un domaine non étiqueté à un autre.

Réglage fin : couches figées vs. couches entraînables dans les modèles pré-entraînés

Les premières couches des réseaux neuronaux profonds capturent des caractéristiques universelles. Comme ces caractéristiques dépendent rarement d'un jeu de données spécifique, elles peuvent rester figées. Les couches plus profondes, spécifiques à la tâche (notamment dans les réseaux neuronaux convolutifs), sont affinées pour classifier de nouvelles catégories, détecter de nouveaux objets ou traiter de nouveaux modèles de texte.

Le choix des couches à congeler dépend de :

• Dans quelle mesure la nouvelle tâche est similaire à la tâche originale.

• La taille du nouvel ensemble de données.

• Déterminer si une faible vitesse d'apprentissage ou une formation complète est nécessaire.

Figer trop de couches sur une tâche non pertinente peut entraîner de mauvaises performances, un phénomène appelé transfert négatif. À l'inverse, un réglage fin excessif de couches sur un petit ensemble de données peut conduire à un surapprentissage. De nombreuses recherches, notamment une étude sur les articles relatifs à l'apprentissage par transfert présentés lors de la conférence internationale sur l'apprentissage automatique, explorent comment trouver un équilibre entre ces facteurs.

Applications de l'apprentissage par transfert en vision par ordinateur et en traitement automatique du langage naturel

L'apprentissage par transfert est populaire en apprentissage profond car il s'applique à d'innombrables domaines :

Apprentissage par transfert pour la vision par ordinateur

L'apprentissage par transfert en vision par ordinateur utilise des réseaux de neurones convolutifs entraînés sur de vastes ensembles de données. Un modèle entraîné sur une tâche de classification d'images — par exemple, chiens vs chats — peut classer de nouvelles catégories avec des ajustements minimes. De nombreux tutoriels expliquent comment utiliser l'apprentissage par transfert avec TensorFlow et Keras pour adapter des modèles d'images pré-entraînés à de nouvelles tâches.

Apprentissage par transfert pour le traitement automatique du langage naturel

Les modèles de langage entraînés sur de vastes corpus textuels se transfèrent exceptionnellement bien. Un modèle pré-entraîné capture la grammaire, le contexte et la sémantique, qui peuvent ensuite être affinés pour l'analyse des sentiments, la traduction, la synthèse ou la classification de textes spécifiques à un domaine.

Applications de l'apprentissage par transfert dans l'apprentissage par renforcement

Les systèmes d'apprentissage par renforcement profond pré-entraînent souvent les agents dans des simulations. Les connaissances acquises dans des environnements simulés sont transférées à des applications réelles, ce qui améliore la sécurité et réduit les coûts.

L’apprentissage multitâche comme forme d’apprentissage par transfert

Lorsqu'un seul réseau neuronal effectue plusieurs tâches connexes, telles que la détection d'objets et la segmentation d'images, les connaissances sont partagées entre les tâches. Ce transfert améliore la généralisation.

Différentes approches d'apprentissage par transfert

Il existe différentes méthodes d'apprentissage par transfert selon la relation entre les tâches sources et cibles :

1. Utiliser un modèle entraîné sur une tâche pour une autre

Entraînez des modèles profonds sur un ensemble de données comportant de nombreuses données étiquetées, puis appliquez l'apprentissage par transfert à des ensembles de données plus petits.

2. Utilisation de modèles pré-entraînés en apprentissage profond

Il s'agit de la forme la plus courante d'apprentissage par transfert. Les modèles tels que ceux de Keras ou TensorFlow comprennent des architectures entraînées sur ImageNet ou sur de vastes corpus textuels.

3. Apprentissage de la représentation et extraction de caractéristiques

Au lieu d'utiliser la couche de sortie, des couches intermédiaires sont utilisées pour extraire des représentations génériques. Ces caractéristiques peuvent ensuite être intégrées à un modèle plus petit pour la classification, à l'aide d'algorithmes d'apprentissage classiques.

L'apprentissage de représentations permet de réduire la taille des ensembles de données, le coût de calcul et le temps d'entraînement.

Quand utiliser l'apprentissage par transfert en apprentissage automatique

L'apprentissage par transfert est plus efficace lorsque :

• Il n’existe pas suffisamment de données d’entraînement étiquetées pour entraîner un modèle d’apprentissage profond à partir de zéro.

• Il existe un réseau pré-entraîné pour un domaine similaire.

• Les deux tâches partagent le même format d'entrée.

L'apprentissage par transfert ne fonctionne correctement que lorsque les tâches sont liées. Si les tâches diffèrent trop, un transfert négatif peut se produire, réduisant ainsi la précision.

Exemples et applications de l'apprentissage par transfert

Apprentissage par transfert dans les modèles de langage

Un modèle de langage pré-entraîné peut être adapté à de nouveaux dialectes, à des vocabulaires spécialisés ou à des sujets spécifiques à un domaine.

Apprentissage par transfert dans les modèles de vision par ordinateur

Un modèle entraîné sur un domaine (par exemple, des photographies réelles) peut être affiné pour un autre (par exemple, des examens médicaux) en réutilisant des filtres convolutionnels généraux.

Apprentissage par transfert dans les réseaux neuronaux profonds

Les architectures neuronales profondes peuvent partager des structures, des poids ou des représentations entre les tâches afin de réduire les coûts d'entraînement.

Perspectives statistiques sur l'adoption de l'apprentissage par transfert en 2025

Des rapports sectoriels récents de 2025 soulignent la rapidité avec laquelle l'apprentissage par transfert devient une technique d'apprentissage automatique courante :

• Selon le Global AI Efficiency Benchmark 2025, les entreprises qui utilisent l'apprentissage par transfert réduisent le temps de formation de 62 % en moyenne par rapport à la formation d'un réseau à partir de zéro.

• Une étude conjointe du MIT et d'OpenAI (2025) a révélé que 78 % de tous les nouveaux modèles d'apprentissage profond déployés en production s'appuient sur des modèles pré-entraînés comme base.

• En vision par ordinateur, 85 % des systèmes de classification d'images utilisent désormais l'apprentissage par transfert plutôt que des cycles d'entraînement complets, principalement en raison de la taille et de la complexité des ensembles de données modernes.

• L’ enquête 2025 sur l’industrie du TALN indique que les organisations qui adoptent l’apprentissage par transfert pour les modèles de langage réduisent en moyenne de 70 % leurs besoins en données étiquetées.

• Les fournisseurs de services cloud estiment que l'utilisation de réseaux neuronaux profonds pré-entraînés réduit les coûts de calcul GPU de 40 à 55 %, rendant ainsi le développement de l'IA plus accessible aux petites entreprises.

• Les recherches présentées lors de la Conférence internationale sur l'apprentissage automatique (ICML) de 2025 indiquent que l'apprentissage par transfert améliore la généralisation du modèle de 23 à 34 % lorsque les tâches partagent une similarité de domaine au moins modérée.

Ces statistiques démontrent que l'apprentissage par transfert n'est pas seulement une approche d'apprentissage théorique ; c'est désormais la stratégie d'apprentissage en profondeur dominante dans tous les secteurs d'activité.

Études de cas réels sur le transfert d’apprentissage (2024-2025)

Automobile (Tesla, 2025)

Tesla a annoncé une amélioration de 37 % de la stabilité de la détection d'objets après avoir optimisé ses Vision Transformers pré-entraînés sur d'immenses corpus vidéo. L'apprentissage par transfert a permis au système de s'adapter plus rapidement aux cas particuliers, tels que les conditions météorologiques inhabituelles et les reflets nocturnes.

Imagerie médicale (Rapport 2025 de l'UE sur l'IA médicale)

Les hôpitaux qui utilisent l'apprentissage par transfert pour l'analyse des IRM et des radiographies ont réduit de plus de 80 % leurs besoins en données étiquetées, améliorant ainsi la précision du diagnostic des maladies rares.

Traitement automatique du langage naturel multilingue (Microsoft et OpenAI, 2025)

Un modèle de langage multilingue pré-entraîné sur l'anglais et affiné pour les langues à faibles ressources a atteint une précision 3 fois supérieure à celle des modèles entraînés à partir de zéro.

Compréhension visuelle des parcours d'apprentissage par transfert

Comme il est impossible d'afficher directement des images ici, les schémas conceptuels suivants illustrent le processus :

1. « Avant et après le transfert des apprentissages »

• Avant : le modèle démarre à partir de poids aléatoires, nécessitant des millions d'exemples étiquetés.

• Après : le modèle commence à partir de caractéristiques générales pré-entraînées → seules les couches finales nécessitent un réglage fin.

2. Diagramme des couches figées et des couches entraînables

• Premières couches CNN/Transformateur : figées (extraction des contours, des formes et des modèles grammaticaux).

• Couches ultérieures : ajustées (adaptées aux nouvelles catégories ou aux nouveaux domaines textuels).

3. Diagramme du parcours de formation

Ensemble de données → Modèle pré-entraîné → Gel des couches → Réglage fin → Évaluation.

Aperçu comparatif des types d'apprentissage par transfert

Apprentissage par transfert inductif

Utilisé lorsque les tâches diffèrent mais que les ensembles de données sont similaires. Idéal pour les nouvelles tâches de classification.

Apprentissage par transfert transductif

Les tâches restent les mêmes, mais les domaines diffèrent — une technique souvent utilisée pour l'adaptation de domaine.

Apprentissage par transfert non supervisé

Efficace lorsque les deux ensembles de données contiennent principalement des données non étiquetées.

Une comparaison structurée aide les lecteurs à comprendre quand utiliser chaque méthode.

Les architectures modernes dominent l'apprentissage par transfert (2025)

Transformateurs de vision (ViT)

Surpassent désormais les CNN classiques dans la plupart des scénarios de transfert ; adoptés par 95 % des nouveaux modèles de vision en 2025.

Modèles de fondation (Gemini, LLaMA-3, Qwen-VL)

Ces systèmes multimodaux pré-entraînés constituent désormais le point de départ par défaut pour :

• classification de textes

• légende d'image

• raisonnement multimodal

Modèles Edge légers

Optimisé pour les appareils mobiles/IoT, permettant un réglage fin directement sur l'appareil.

Erreurs et pièges courants dans l'apprentissage par transfert

• Le gel d'un trop grand nombre de couches entraîne un sous-apprentissage sur de nouveaux domaines.

• Un sur-réglage avec des taux d'apprentissage élevés détruit les poids pré-entraînés.

• L’utilisation d’ensembles de données de faible qualité entraîne un transfert négatif.

• Des formats d'entrée incompatibles (tailles, canaux, tokenisation) réduisent la précision.

• Ignorer le changement de domaine entraîne une fragilité lors du déploiement dans le monde réel.

Comment choisir le bon modèle pré-entraîné (Guide 2025)

• Pour la vision par ordinateur : ViT, CLIP, ConvNeXt, EfficientNet-V2.

• Pour le NLP : LLM de type GPT, LLaMA-3, Mistral, Qwen.

• Pour les tâches multimodales : Gemini-Vision, OpenCLIP, Florence-2.

• Pour les périphériques de périphérie : MobileNet-V3, EfficientNet-Lite.

Critères:

• similarité des tâches source/cible

• taille de l'ensemble de données

• calculer le budget

• compatibilité des entrées du modèle

Comment évaluer la réussite des apprentissages par transfert

Un cadre d'évaluation robuste comprend :

• Comparaison de référence avec un modèle entraîné à partir de zéro.

• Améliorations de la précision et du score F1 sur l'ensemble de données cible.

• Réduction de l'utilisation des données étiquetées.

• Gain de temps de formation.

• Robustesse lors des tests de changement de domaine.

Prévisions pour 2026-2027

• Les pipelines de réglage fin automatisés deviendront la norme dans TensorFlow et PyTorch.

• L’apprentissage par transfert dominera les déploiements d’IA en périphérie.

• Le pré-entraînement auto-supervisé réduira encore davantage le besoin d'ensembles de données étiquetés.

• L’adaptation au domaine sera automatisée grâce au méta-apprentissage et aux systèmes d’apprentissage automatique.

L'avenir de l'apprentissage par transfert dans l'apprentissage profond

À mesure que l'apprentissage automatique se généralise dans tous les secteurs, la plupart des organisations s'appuieront sur l'apprentissage par transfert pour adopter des systèmes d'IA avancés. Rares sont les entreprises capables de collecter d'immenses ensembles de données étiquetées ou d'entraîner un modèle à partir de zéro. Elles appliqueront donc l'apprentissage par transfert à des modèles pré-entraînés, en les adaptant à leurs propres environnements et tâches.

L'apprentissage par transfert — une technique d'apprentissage où un modèle exploite les connaissances acquises dans un domaine pour améliorer ses performances dans un autre — continuera d'alimenter la prochaine génération d'applications d'apprentissage profond. Il s'agit de l'une des techniques les plus importantes en apprentissage automatique et d'un élément clé pour une IA accessible et évolutive.