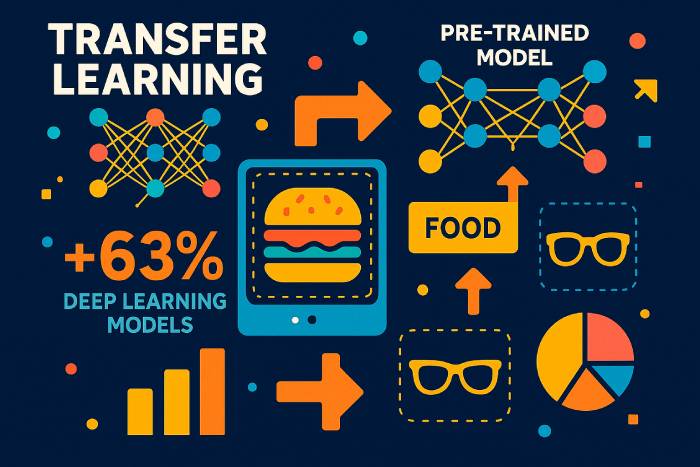

Transfer Pembelajaran dalam Pembelajaran Mendalam dan Jaringan Saraf

Pembelajaran transfer adalah teknik pembelajaran mesin di mana model pembelajaran yang dilatih pada satu tugas digunakan kembali untuk mempercepat dan meningkatkan performa pada tugas terkait. Alih-alih melatih jaringan saraf tiruan dari awal pada set data baru, pembelajaran transfer memungkinkan pengembang untuk menggunakan kembali pengetahuan yang telah dipelajari model dalam satu pengaturan dan menerapkannya ke pengaturan lain. Dengan demikian, model yang dilatih pada satu masalah dapat meningkatkan generalisasi pada masalah lain — terutama ketika data berlabel untuk tugas baru tersebut terbatas.

Dalam pembelajaran mesin modern, pendekatan ini telah menjadi pendorong kemajuan pembelajaran mesin. Pembelajaran mendalam membutuhkan kumpulan data yang sangat besar, perangkat keras canggih, dan siklus pelatihan yang panjang. Pembelajaran transfer—suatu bentuk transfer pengetahuan—mengurangi biaya tersebut dengan membiarkan model yang dilatih pada kumpulan data besar seperti ImageNet berfungsi sebagai basis untuk model baru. Strategi ini banyak digunakan dalam visi komputer, pemrosesan bahasa alami, pembelajaran penguatan, dan banyak lembaga penelitian yang mengeksplorasi teknik-teknik dalam pembelajaran mesin.

Pembelajaran transfer melibatkan penggunaan kembali lapisan, fitur, atau keseluruhan arsitektur model sehingga tugas baru dapat dimulai dari representasi yang telah dipelajari, alih-alih dari awal. Karena lapisan awal jaringan saraf konvolusional mempelajari fitur-fitur universal seperti tepi dan tekstur, dan lapisan awal model bahasa mempelajari tata bahasa dan struktur, bagian-bagian ini dapat ditransfer dengan baik ke berbagai tugas dan domain.

Manfaat Transfer Learning dalam Pembelajaran Mesin

Model pembelajaran mesin seringkali bergantung pada data berlabel dalam jumlah besar. Pengumpulan dan pelabelan set data tersebut mahal dan lambat. Pembelajaran transfer mengatasi hal ini dengan memungkinkan pengembang menggunakan model yang telah dilatih sebelumnya, alih-alih membangun jaringan dari awal. Manfaat pembelajaran transfer meliputi:

• Penggunaan data pelatihan yang lebih efisien, terutama ketika data berlabel langka.

• Proses pembelajaran lebih cepat dan biaya komputasi berkurang.

• Performa yang lebih baik pada tugas baru karena lapisan awal menangkap pola yang ditransfer dengan baik.

• Dukungan untuk aplikasi pembelajaran di seluruh domain tempat model dapat digunakan dan diadaptasi.

Seiring pembelajaran mesin menjadi bagian integral dari berbagai industri, mulai dari layanan kesehatan hingga keuangan, kemampuan untuk menerapkan transfer pembelajaran menjadi semakin penting. Model yang dilatih pada set data besar dapat disempurnakan dengan laju pembelajaran rendah agar berkinerja baik pada tugas baru yang terkait.

Cara Kerja Transfer Learning dalam Model Pembelajaran Mendalam

Pembelajaran transfer bekerja dengan mengambil bagian-bagian dari model yang telah dilatih sebelumnya — biasanya ekstraktor fitur umum — dan menggunakannya kembali untuk tugas baru. Ini melibatkan langkah-langkah seperti:

Pilih model yang telah dilatih sebelumnya. Model yang dilatih pada kumpulan data besar (misalnya, ImageNet, korpus teks besar, atau kumpulan data audio) berfungsi sebagai basis.

Bekukan lapisan yang menangkap pengetahuan umum. Lapisan ini tetap tidak berubah karena sudah mempelajari representasi yang bermanfaat.

Sempurnakan lapisan yang tersisa. Lapisan selanjutnya dilatih ulang pada set data baru dengan laju pembelajaran yang rendah, sehingga tugas baru dapat beradaptasi tanpa menimpa pembelajaran model.

Latih model untuk membuat prediksi pada tugas terkait. Hanya sebagian model yang perlu disesuaikan, sehingga mengurangi upaya pelatihan secara drastis.

Pendekatan pembelajaran ini mirip dengan pembelajaran transfer induktif, di mana pengetahuan yang dipelajari dalam satu tugas membantu meningkatkan generalisasi di tugas lain. Dalam pembelajaran transfer transduktif, tugasnya tetap sama tetapi kumpulan datanya berubah. Dalam pembelajaran tanpa pengawasan, pembelajaran transfer dapat membantu model beradaptasi dari satu domain tak berlabel ke domain lainnya.

Penyetelan Halus: Lapisan Beku vs. Lapisan yang Dapat Dilatih dalam Model yang Telah Dilatih

Lapisan awal jaringan saraf dalam menangkap fitur-fitur universal. Karena fitur-fitur ini jarang bergantung pada set data tertentu, fitur-fitur ini dapat tetap beku. Lapisan yang lebih dalam dan spesifik untuk tugas tertentu — terutama dalam jaringan saraf konvolusional — disetel dengan baik untuk mengklasifikasikan kategori baru, mendeteksi objek baru, atau memproses pola teks baru.

Memilih lapisan mana yang akan dibekukan bergantung pada:

• Seberapa mirip tugas baru tersebut dengan tugas aslinya.

• Seberapa besar atau kecil kumpulan data baru tersebut.

• Apakah diperlukan tingkat pembelajaran kecil atau pelatihan ulang penuh.

Membekukan terlalu banyak lapisan pada tugas yang tidak terkait dapat menyebabkan kinerja yang buruk, yang dikenal sebagai transfer negatif. Namun, menyempurnakan terlalu banyak lapisan pada set data kecil dapat menyebabkan overfitting. Banyak penelitian, termasuk survei tentang makalah pembelajaran transfer dari konferensi internasional tentang pembelajaran mesin, mengeksplorasi cara menyeimbangkan faktor-faktor ini.

Aplikasi Transfer Learning dalam Visi Komputer dan NLP

Pembelajaran transfer populer dalam pembelajaran mendalam karena dapat diterapkan di berbagai domain yang tak terhitung jumlahnya:

Transfer Pembelajaran untuk Visi Komputer

Pembelajaran transfer untuk visi komputer menggunakan jaringan saraf konvolusional yang dilatih pada set data besar. Model yang dilatih pada satu tugas klasifikasi gambar—misalnya anjing vs. kucing—dapat mengklasifikasikan kategori baru dengan penyesuaian minimal. Banyak tutorial menunjukkan cara menggunakan pembelajaran transfer dengan TensorFlow dan Keras untuk mengadaptasi model gambar yang telah dilatih sebelumnya ke tugas-tugas baru.

Transfer Pembelajaran untuk Pemrosesan Bahasa Alami

Model bahasa yang dilatih pada korpus teks masif memberikan transfer data yang sangat baik. Model yang telah dilatih sebelumnya mampu menangkap tata bahasa, konteks, dan semantik, yang kemudian dapat disempurnakan untuk analisis sentimen, penerjemahan, peringkasan, atau klasifikasi teks spesifik domain.

Aplikasi Pembelajaran Transfer dalam Pembelajaran Penguatan

Sistem pembelajaran penguatan mendalam sering kali melatih agen terlebih dahulu dalam simulasi. Pengetahuan yang diperoleh dalam lingkungan simulasi dapat diterapkan di dunia nyata, sehingga meningkatkan keselamatan dan mengurangi biaya.

Pembelajaran Multi-Tugas sebagai Bentuk Pembelajaran Transfer

Ketika satu jaringan saraf melakukan beberapa tugas terkait — seperti deteksi objek dan segmentasi gambar — pengetahuan dibagikan di antara tugas-tugas tersebut. Bentuk transfer ini meningkatkan generalisasi.

Berbagai Pendekatan Pembelajaran Transfer

Terdapat berbagai metode pembelajaran transfer tergantung pada hubungan antara tugas sumber dan tugas target:

1. Menggunakan Model yang Dilatih pada Satu Tugas untuk Tugas Lainnya

Latih model mendalam pada kumpulan data dengan data berlabel yang melimpah, lalu terapkan pembelajaran transfer ke kumpulan data yang lebih kecil.

2. Menggunakan Model Terlatih dalam Pembelajaran Mendalam

Ini adalah bentuk pembelajaran transfer yang paling umum. Model seperti yang ada di Keras atau TensorFlow mencakup arsitektur yang dilatih pada ImageNet atau korpora teks besar.

3. Pembelajaran Representasi dan Ekstraksi Fitur

Alih-alih menggunakan lapisan keluaran, lapisan perantara digunakan untuk mengekstrak representasi umum. Fitur-fitur ini kemudian dapat dimasukkan ke dalam model yang lebih kecil untuk klasifikasi menggunakan algoritma pembelajaran tradisional.

Pembelajaran representasi membantu mengurangi ukuran kumpulan data, biaya komputasi, dan waktu pelatihan.

Kapan Menggunakan Transfer Learning dalam Pembelajaran Mesin

Pembelajaran transfer paling efektif ketika:

• Tidak ada cukup data pelatihan berlabel untuk melatih model pembelajaran mendalam dari awal.

• Jaringan yang telah dilatih sebelumnya tersedia untuk domain yang serupa.

• Kedua tugas berbagi format masukan yang sama.

Pembelajaran transfer hanya efektif jika tugas-tugasnya saling terkait. Jika tugas-tugasnya terlalu berbeda, transfer negatif dapat terjadi, yang mengurangi akurasi.

Contoh dan Aplikasi Transfer Learning

Pembelajaran Transfer dalam Model Bahasa

Model bahasa yang telah dilatih sebelumnya dapat disesuaikan dengan dialek baru, kosakata khusus, atau topik khusus domain.

Pembelajaran Transfer dalam Model Visi Komputer

Model yang dilatih pada satu domain (misalnya, foto asli) dapat disesuaikan untuk domain lain (misalnya, pemindaian medis) dengan menggunakan kembali filter konvolusional umum.

Pembelajaran Transfer dalam Jaringan Saraf Dalam

Arsitektur saraf dalam dapat berbagi struktur, bobot, atau representasi antartugas untuk menurunkan biaya pelatihan.

Wawasan Statistik 2025 tentang Adopsi Pembelajaran Transfer

Laporan industri terbaru tahun 2025 menyoroti seberapa cepat pembelajaran transfer menjadi teknik pembelajaran mesin yang utama:

• Menurut Tolok Ukur Efisiensi AI Global 2025, perusahaan yang menggunakan pembelajaran transfer mengurangi waktu pelatihan rata-rata 62% dibandingkan dengan melatih jaringan dari awal.

• Sebuah studi bersama oleh MIT & OpenAI (2025) menemukan bahwa 78% dari semua model pembelajaran mendalam baru yang diterapkan dalam produksi mengandalkan model yang telah dilatih sebelumnya sebagai fondasinya.

• Dalam visi komputer, 85% sistem klasifikasi gambar sekarang menggunakan pembelajaran transfer daripada siklus pelatihan penuh, sebagian besar karena ukuran dan kompleksitas kumpulan data modern.

• Survei Industri NLP 2025 melaporkan bahwa organisasi yang mengadopsi pembelajaran transfer untuk model bahasa memangkas persyaratan data berlabel rata-rata sebesar 70%.

• Penyedia cloud memperkirakan bahwa penggunaan jaringan saraf dalam yang telah dilatih sebelumnya mengurangi biaya komputasi GPU hingga 40–55%, membuat pengembangan AI lebih mudah diakses oleh perusahaan yang lebih kecil.

• Penelitian yang dipresentasikan pada Konferensi Internasional tentang Pembelajaran Mesin (ICML) 2025 menunjukkan bahwa pembelajaran transfer meningkatkan generalisasi model sebesar 23–34% ketika tugas berbagi setidaknya kesamaan domain sedang.

Statistik ini menunjukkan bahwa pembelajaran transfer bukan sekadar pendekatan pembelajaran teoretis — kini menjadi strategi pembelajaran mendalam yang dominan di seluruh industri.

Studi Kasus Dunia Nyata tentang Pembelajaran Transfer (2024–2025)

Otomotif (Tesla, 2025)

Tesla melaporkan peningkatan stabilitas deteksi objek sebesar 37% setelah menyempurnakan Vision Transformers yang telah dilatih sebelumnya pada korpus video masif. Pembelajaran transfer memungkinkan sistem beradaptasi lebih cepat terhadap kasus-kasus langka seperti pola cuaca yang tidak biasa dan pantulan cahaya di malam hari.

Pencitraan Layanan Kesehatan (Laporan AI Medis Uni Eropa 2025)

Rumah sakit yang menggunakan pembelajaran transfer untuk analisis MRI dan sinar-X mengurangi persyaratan data berlabel lebih dari 80%, meningkatkan akurasi diagnosis untuk penyakit langka.

NLP Multibahasa (Microsoft & OpenAI, 2025)

Model bahasa multibahasa yang dilatih sebelumnya dalam bahasa Inggris dan disesuaikan untuk bahasa dengan sumber daya rendah mencapai akurasi 3x lebih baik daripada model yang dilatih dari awal.

Pemahaman Visual tentang Alur Pembelajaran Transfer

Karena gambar tidak dapat ditampilkan langsung di sini, diagram konseptual berikut memperjelas prosesnya:

1. “Pembelajaran Transfer Sebelum vs Sesudah”

• Sebelum: model dimulai dari bobot acak, membutuhkan jutaan contoh berlabel.

• Sesudah: model dimulai dari fitur umum yang telah dilatih sebelumnya → hanya lapisan akhir yang perlu disempurnakan.

2. Diagram Lapisan Beku vs. Lapisan yang Dapat Dilatih

• Lapisan CNN/Transformer awal: dibekukan (ekstrak tepi, bentuk, pola tata bahasa).

• Lapisan selanjutnya: disempurnakan (disesuaikan dengan kategori atau domain teks baru).

3. Diagram Alur Pelatihan

Dataset → Model terlatih → Bekukan lapisan → Penyempurnaan → Evaluasi.

Tinjauan Komparatif Jenis Pembelajaran Transfer

Pembelajaran Transfer Induktif

Digunakan ketika tugas berbeda tetapi set data serupa. Cocok untuk tugas klasifikasi baru.

Pembelajaran Transfer Transduktif

Tugasnya tetap sama, tetapi domainnya berbeda — sering digunakan untuk adaptasi domain.

Pembelajaran Transfer Tanpa Pengawasan

Efektif ketika kedua kumpulan data sebagian besar berisi data yang tidak berlabel.

Perbandingan terstruktur membantu pembaca memahami kapan harus menggunakan setiap metode.

Arsitektur Modern Mendominasi Pembelajaran Transfer (2025)

Transformator Penglihatan (ViT)

Sekarang mengungguli CNN klasik pada sebagian besar skenario transfer; diadopsi oleh 95% model visi baru pada tahun 2025.

Model Fondasi (Gemini, LLaMA-3, Qwen-VL)

Sistem multimoda yang telah dilatih sebelumnya ini sekarang menjadi titik awal default untuk:

• klasifikasi teks

• keterangan gambar

• penalaran multimodal

Model Tepi Ringan

Dioptimalkan untuk perangkat seluler/IoT, memungkinkan penyempurnaan pada perangkat.

Kesalahan dan Jebakan Umum dalam Pembelajaran Transfer

• Membekukan terlalu banyak lapisan menyebabkan underfitting pada domain baru.

• Penyetelan berlebihan dengan tingkat pembelajaran yang tinggi akan merusak bobot yang telah dilatih sebelumnya.

• Penggunaan kumpulan data berkualitas rendah menyebabkan transfer negatif.

• Format input yang tidak cocok (ukuran, saluran, tokenisasi) mengurangi akurasi.

• Mengabaikan pergeseran domain menyebabkan kerapuhan dalam penerapan di dunia nyata.

Cara Memilih Model Pra-Terlatih yang Tepat (Panduan 2025)

• Untuk visi komputer: ViT, CLIP, ConvNeXt, EfficientNet-V2.

• Untuk NLP: LLM gaya GPT, LLaMA-3, Mistral, Qwen.

• Untuk tugas multimoda: Gemini-Vision, OpenCLIP, Florence-2.

• Untuk perangkat edge: MobileNet-V3, EfficientNet-Lite.

Kriteria:

• kesamaan tugas sumber/target

• ukuran kumpulan data

• menghitung anggaran

• kompatibilitas masukan model

Cara Mengevaluasi Keberhasilan Pembelajaran Transfer

Kerangka evaluasi yang kuat meliputi:

• Perbandingan dasar dengan model yang dilatih dari awal.

• Akurasi dan peningkatan F1 pada kumpulan data target.

• Pengurangan penggunaan data berlabel.

• Menghemat waktu pelatihan.

• Ketahanan terhadap uji pergeseran domain.

Prediksi untuk tahun 2026–2027

• Pipa penyetelan halus otomatis akan menjadi standar di TensorFlow dan PyTorch.

• Pembelajaran transfer akan mendominasi penerapan AI tepi.

• Pra-pelatihan yang diawasi sendiri akan semakin mengurangi kebutuhan akan kumpulan data berlabel.

• Adaptasi domain akan diotomatisasi melalui sistem meta-pembelajaran dan belajar untuk belajar.

Masa Depan Pembelajaran Transfer dalam Pembelajaran Mendalam

Seiring meluasnya pembelajaran mesin ke setiap industri, sebagian besar organisasi akan mengandalkan transfer learning untuk mengadopsi sistem AI canggih. Hanya sedikit perusahaan yang mampu mengumpulkan set data berlabel dalam jumlah besar atau melatih model dari awal. Sebagai gantinya, mereka akan menerapkan transfer learning ke model yang telah dilatih sebelumnya, mengadaptasinya ke lingkungan dan tugas mereka sendiri.

Pembelajaran transfer — sebuah teknik pembelajaran di mana model memanfaatkan pengetahuan yang dipelajari dalam satu domain untuk meningkatkan kinerja di domain lain — akan terus mendukung aplikasi pembelajaran mendalam generasi berikutnya. Teknik ini merupakan salah satu teknik terpenting dalam pembelajaran mesin dan pendorong utama AI yang mudah diakses dan terukur.